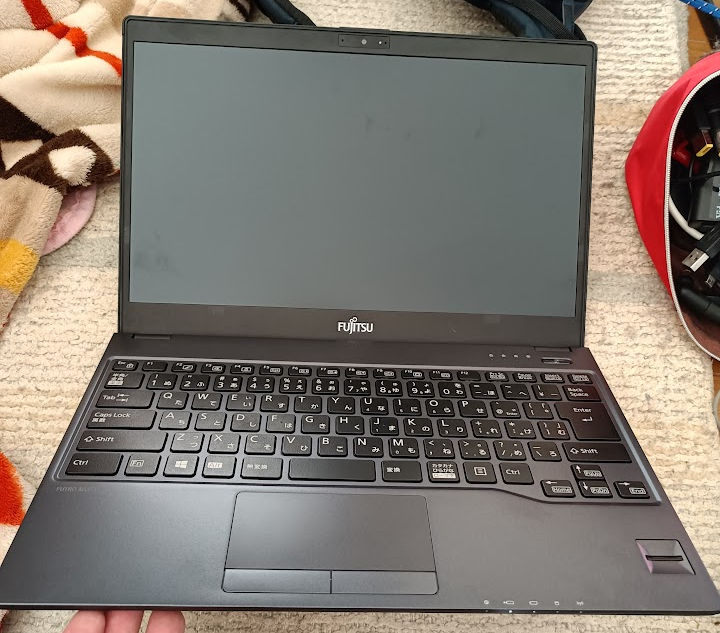

先日の富士通Lifebook S937/R はハズレを引いたようでM.2 SATAがちゃんと動かなかったので、どうしようかなーと思いつつ 旧キャプテンにいくと、ほぼ同じスペックで薄くなっているシンクラ専用機FUTRO MU937が売っていたので買ってみた。

Lifebookと違って普通のWindowsライセンスではなく、Windows 10 IoT 2015 LTSB Valueという特殊なものであるのが難点ですね(もう1台買ったら、そちらはWindows 10 IoT 2016 LTSB Valueでした)

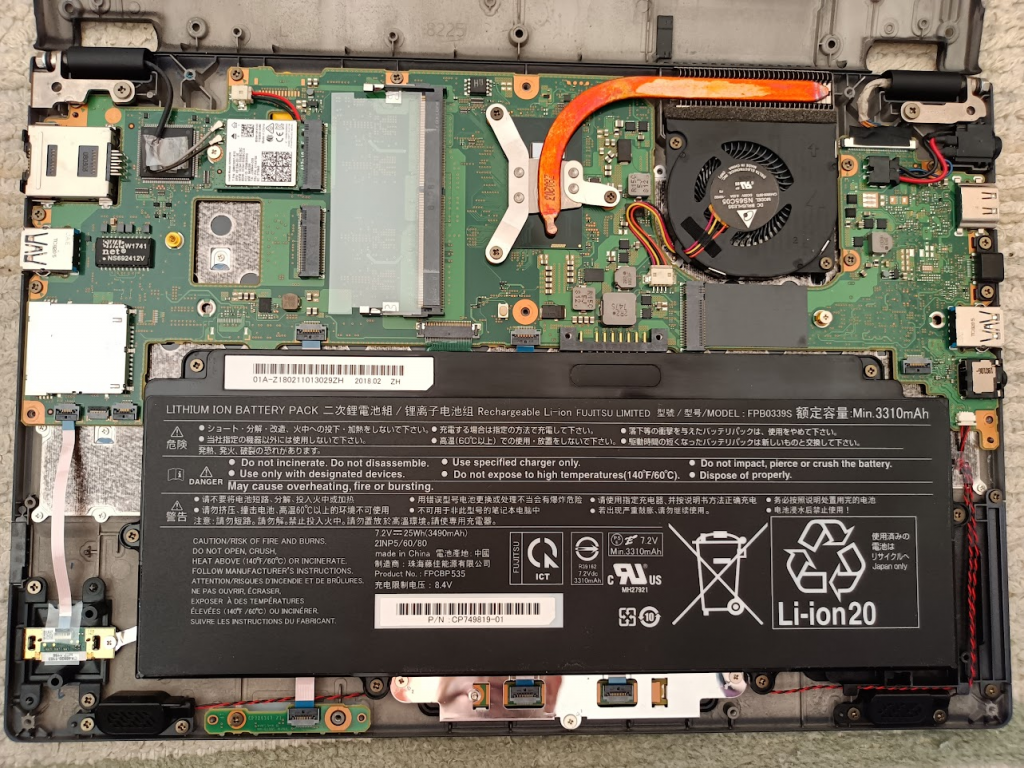

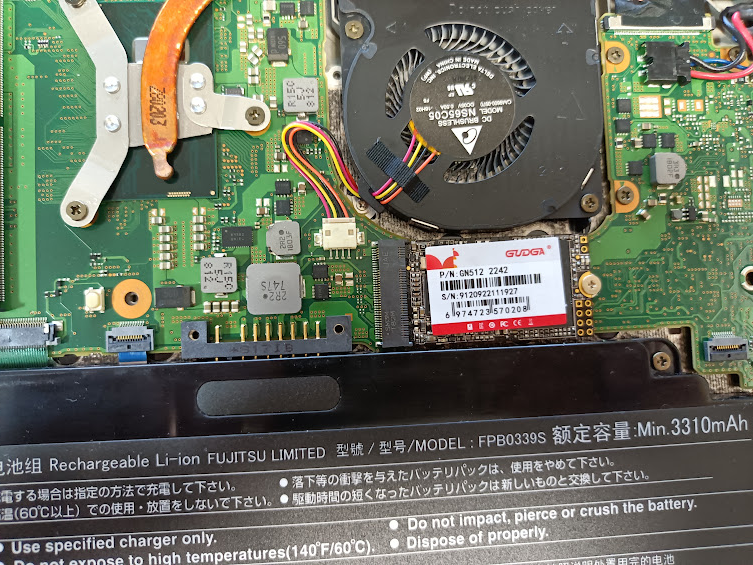

裏面に見えてるネジを外せばすぐに外れる

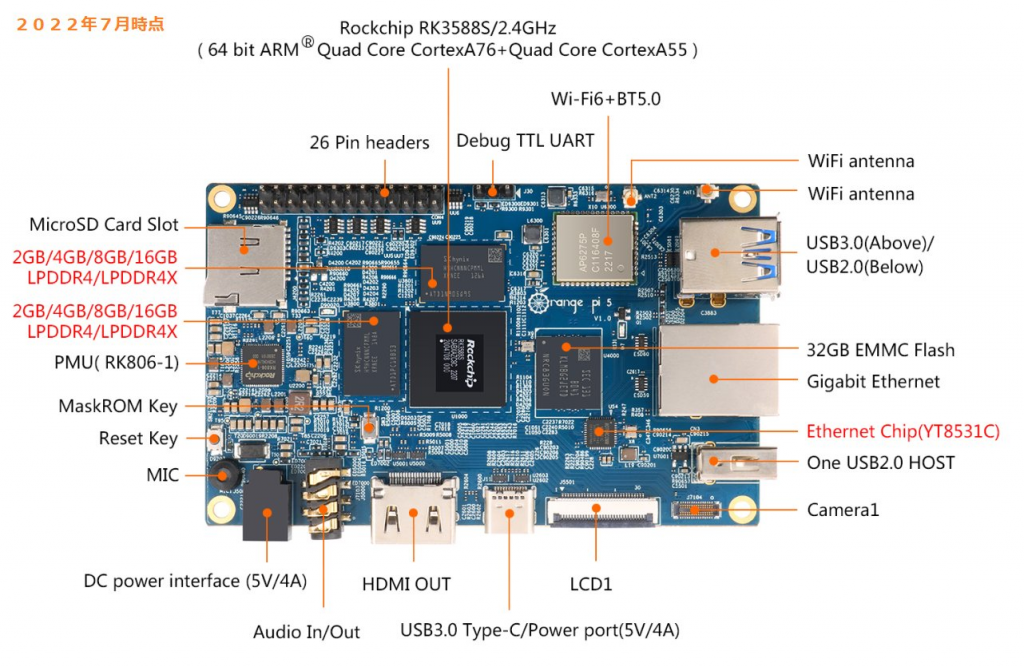

Lifebook S937/Rと同様にDDR4 SO-DIMMスロット1個に

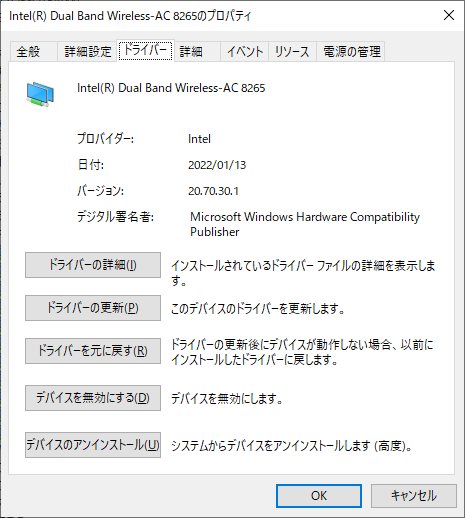

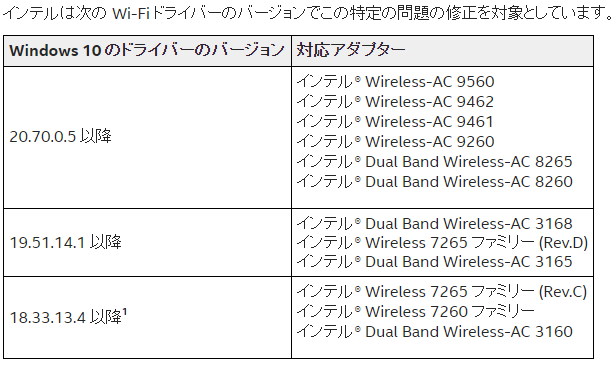

M.2 A-keyスロットにインテル® Dual Band Wireless-AC 8265 (8265NGW)が入ってる。

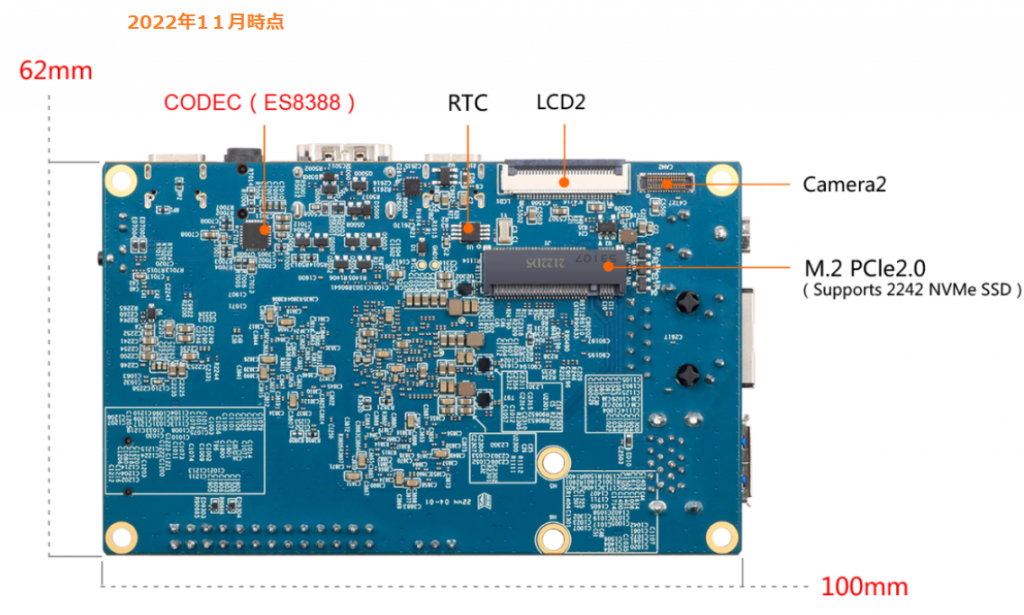

M.2 B-keyスロットは2242サイズ

M.2 M-keyスロットは2280サイズ

ただし、M-keyスロット2242サイズの所にネジが着いていて、2280側にネジを移動させるにはマザーボードを取り外さないと無理そう。

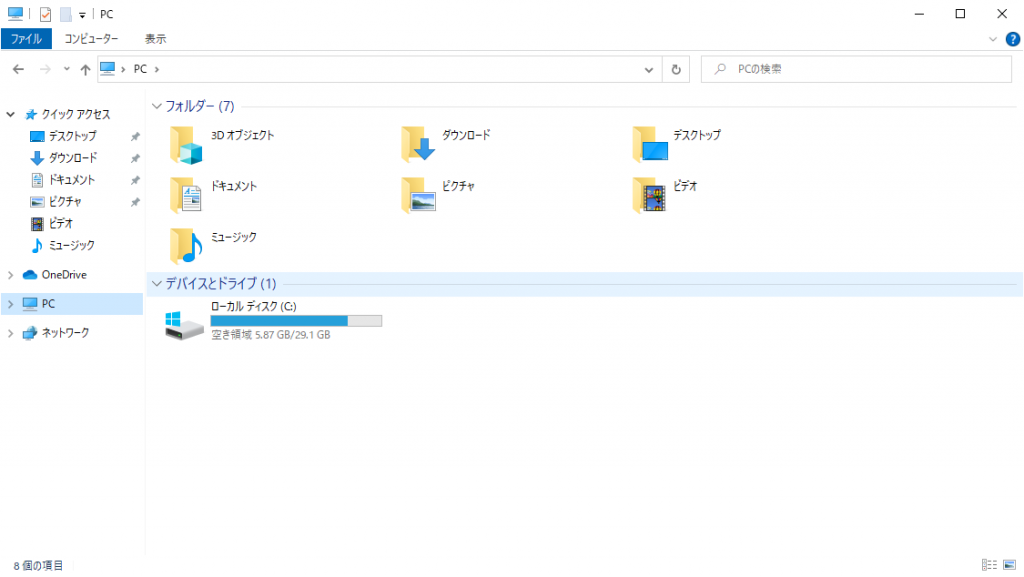

ストレージを認識させてみる

最初、左側の無線ANの下にあるM.2スロットがストレージかと勘違いしてた。

2242サイズのSATAは持ってないので無理矢理2280サイズのやつつけられるかなーと検討してみたけど、USBコネクタがあるので無理でした。

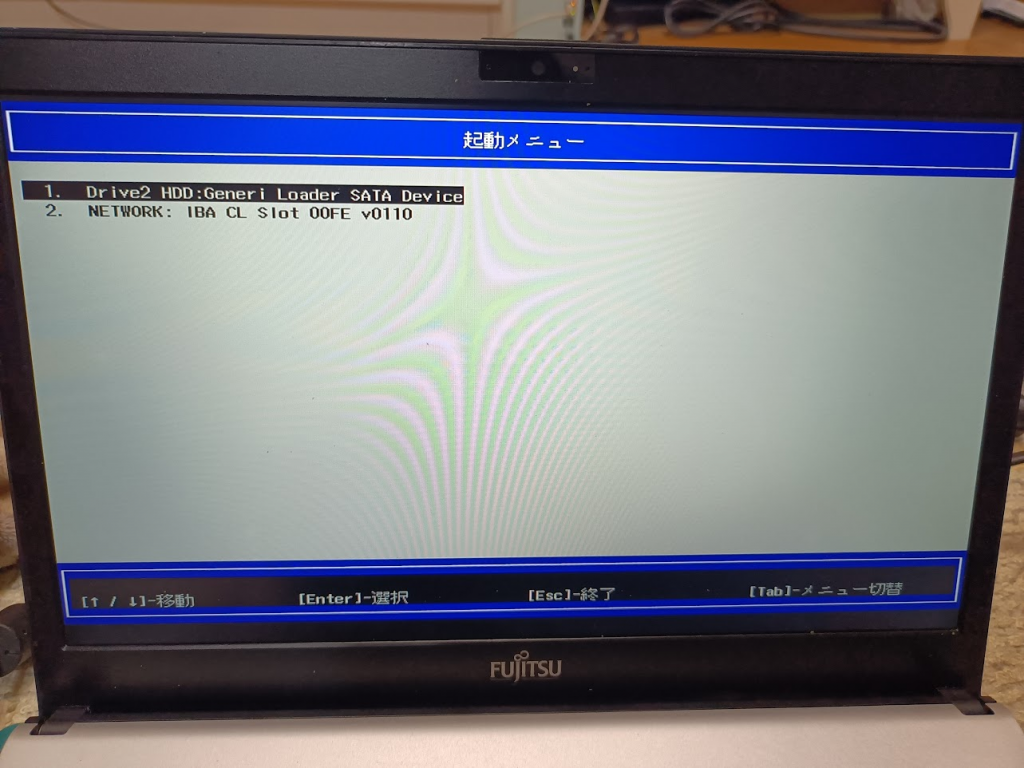

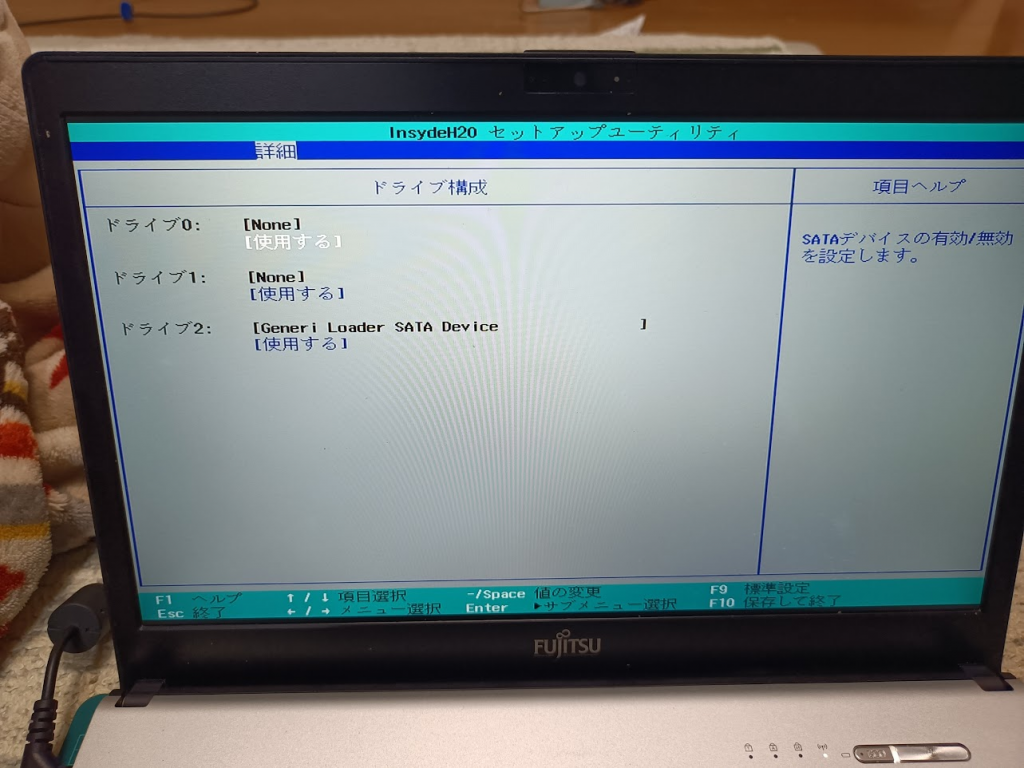

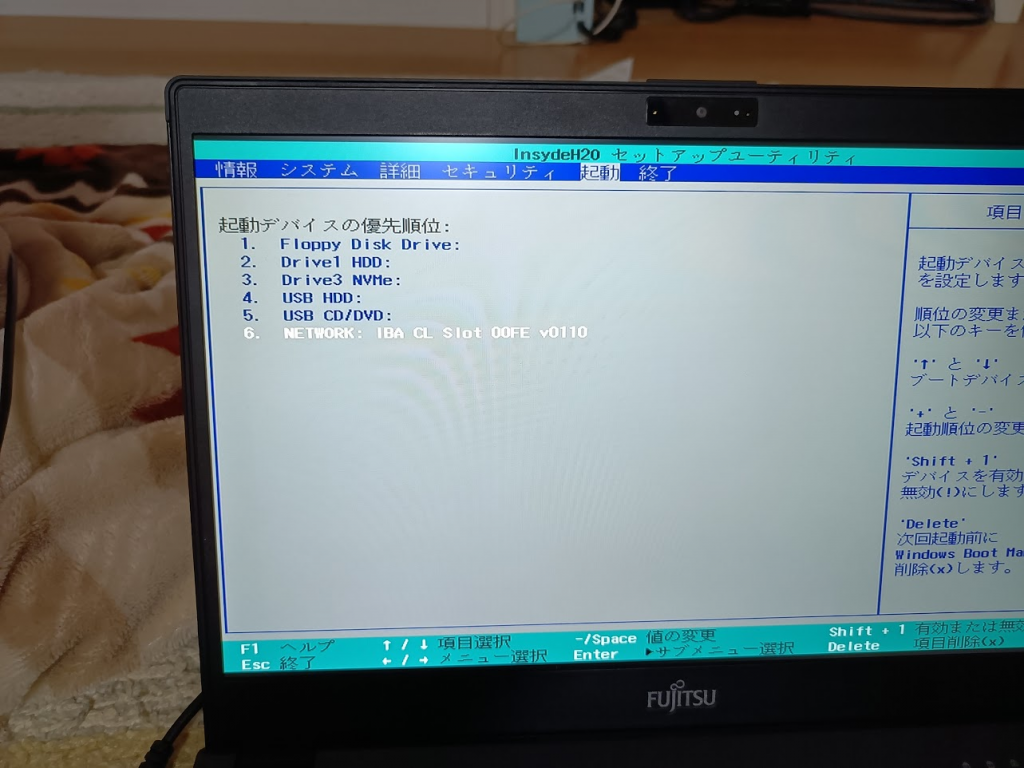

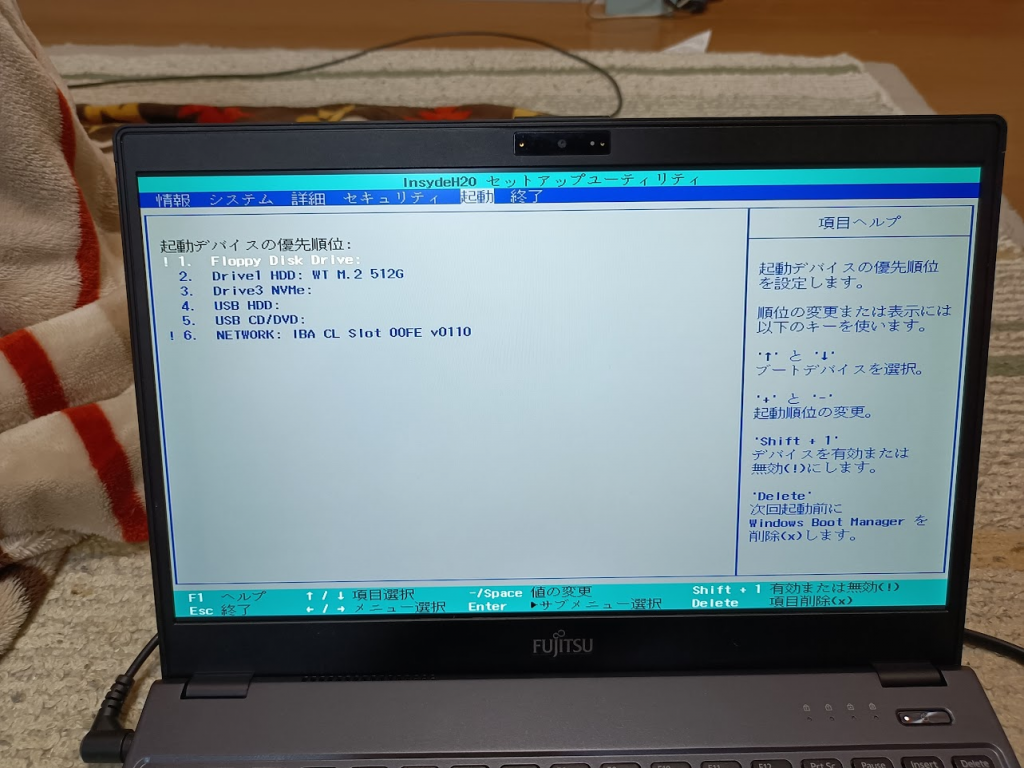

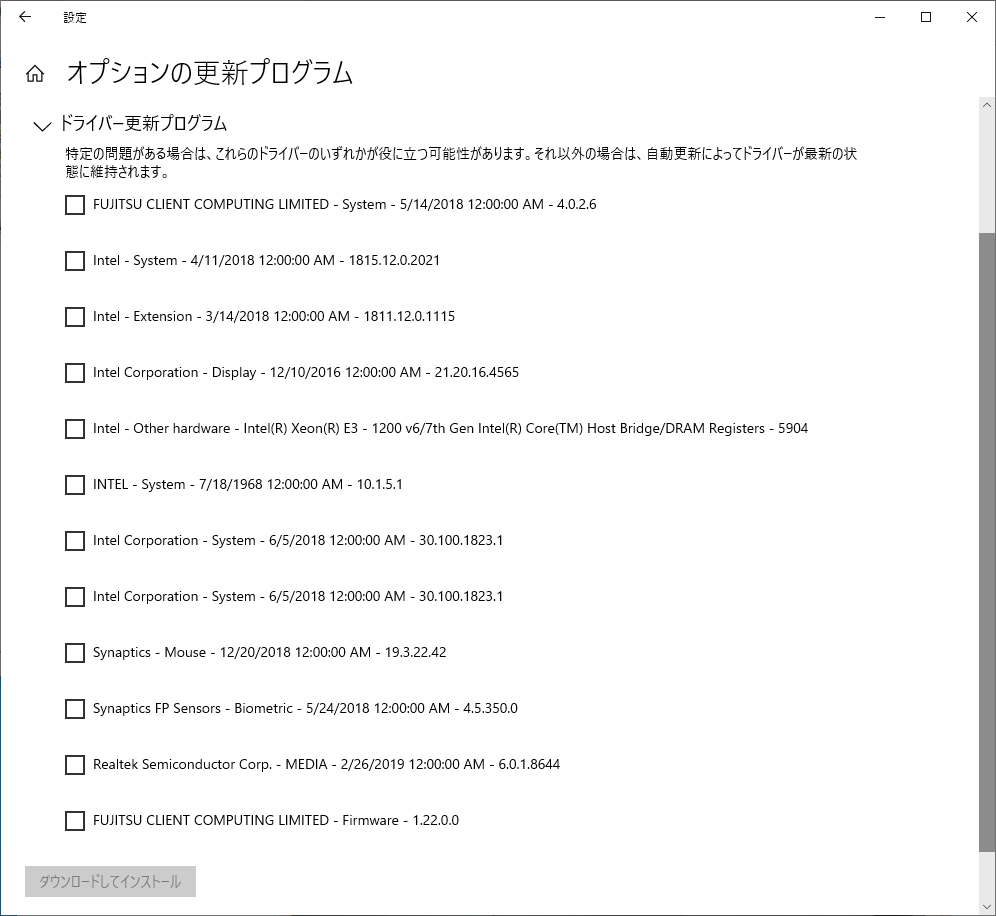

まずはとりあえず起動してみるかとBIOS画面を見てみると「Drive1 HDD」「Drive 3 NVMe」という謎表記

よく見ると右側にあったコネクタが M.2 M-keyコネクタだったのでNVMeストレージを付けてみたけど認識しない

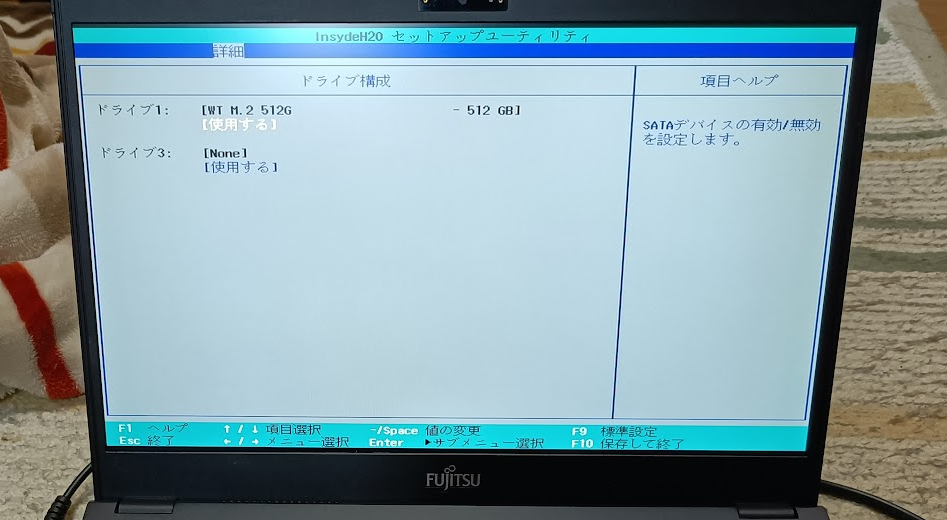

じゃあ、とM.2 SATAストレージをさしてみると認識した。

Drive 1 HDDとして認識された。

となると、Drive 3 NVMeスロットとは何なのだ????

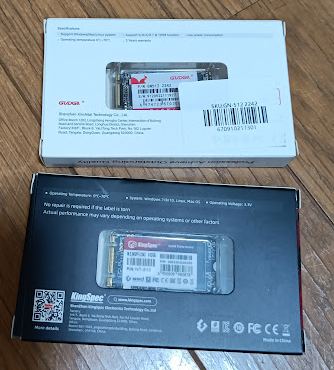

とりあえずAliexpressで2242サイズのM.2 SATA SSDを2種類入手して使っています。

KingSpec M.2 NGFF SSD

512GBを$26.50で買いました

GUDGA M2 2280 SSD M.2 SATA SSD

512GBを$23.65で買いました

詳細は「aliexpressでM.2 2242サイズのSATAとNVMeを買ってみた」にて

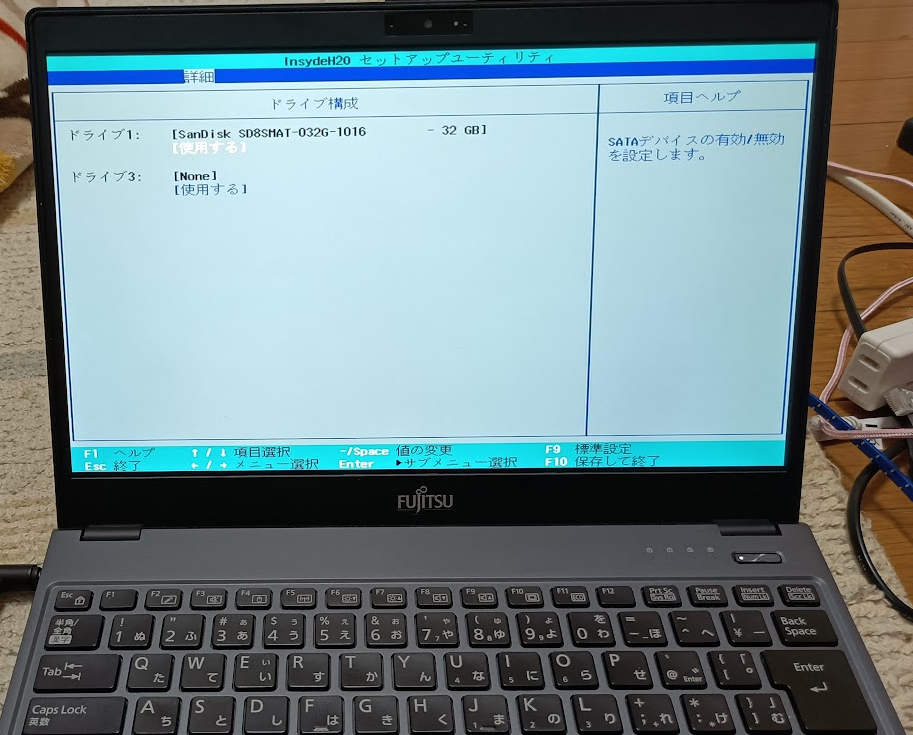

2022/12/30追記

32GB SSDを取り付けた状態のものが販売されたので1台買ってみたところ、SanDisk SD8SMAT-032GBとして認識されていた。

この32GB SSDでも、Windows 10 22H2のインストールは可能でした。

残り容量5GBちょっと、という状態ですけどね

メモリ増設(2023/01/05追記パート)

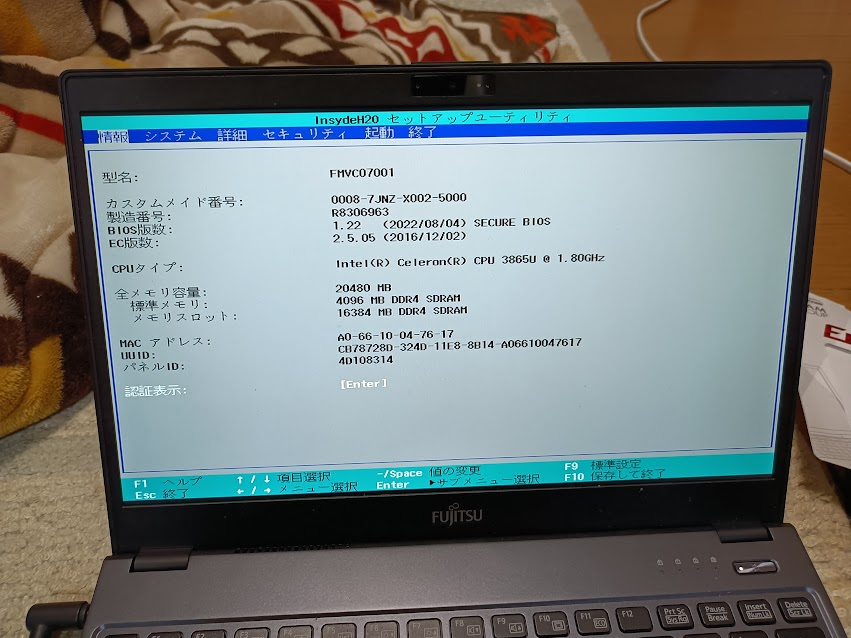

16GB SO-DIMMを増設することで合計20GBメモリとすることができました。

詳細は「富士通LIFEBOOK S937/RとFUTRO MU937は16GB SO-DIMMが増設できてメモリ20GB構成になる」

製品資料

FUTRO MU937に関する資料

FUTROドライバダウンロード起点 → MU937

なお、FUTRO MU937の元となっているのは LIFEBOOK U937/R と思われる。

LIFEBOOKドライバダウンロード起点 → U937/R

MU937とU937/Rとではドライバに関してはほぼ同じで、添付ソフトまわりの取り扱いが異なるようだ。

不思議なのはMU937のBIOSは「LIFEBOOK UH90/B1,UH75/B1,WU2/B1,FUTRO MU937用BIOS書換データ」で、LIFEBOOK U937/Rは「LIFEBOOK U937/P,U937/R,U937/RX用 BIOS書換データ」ということ。同じCPUで同じ構成っぽいけど別枠なんだ・・・

13.3型ワイド ノートパソコン LIFEBOOK UHシリーズ

Windows10インストール概要

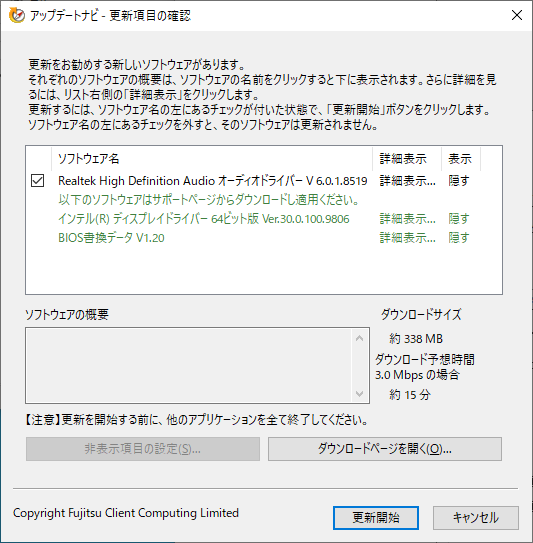

2022/12/13追記: 下の方にある”Windows 10 Home 22H2″のインストール記録ではWindows Updateのみでドライバを適用する場合のドライバ特定方法などを含めた手法を解説していますが、ここに要点を書いておきます。

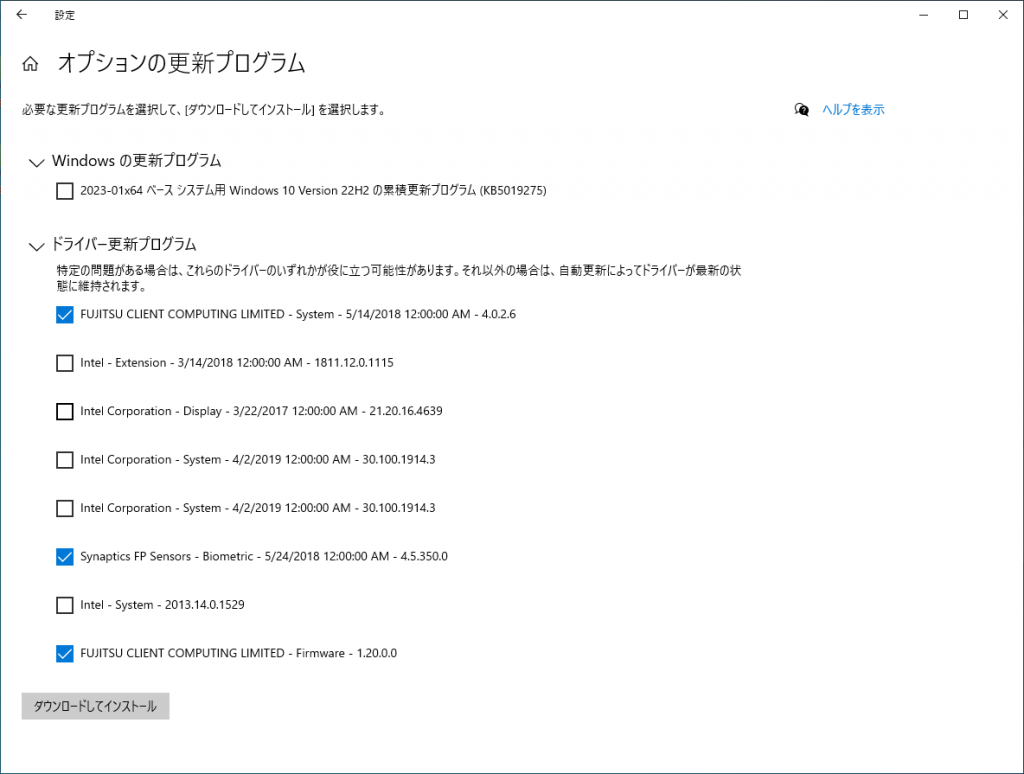

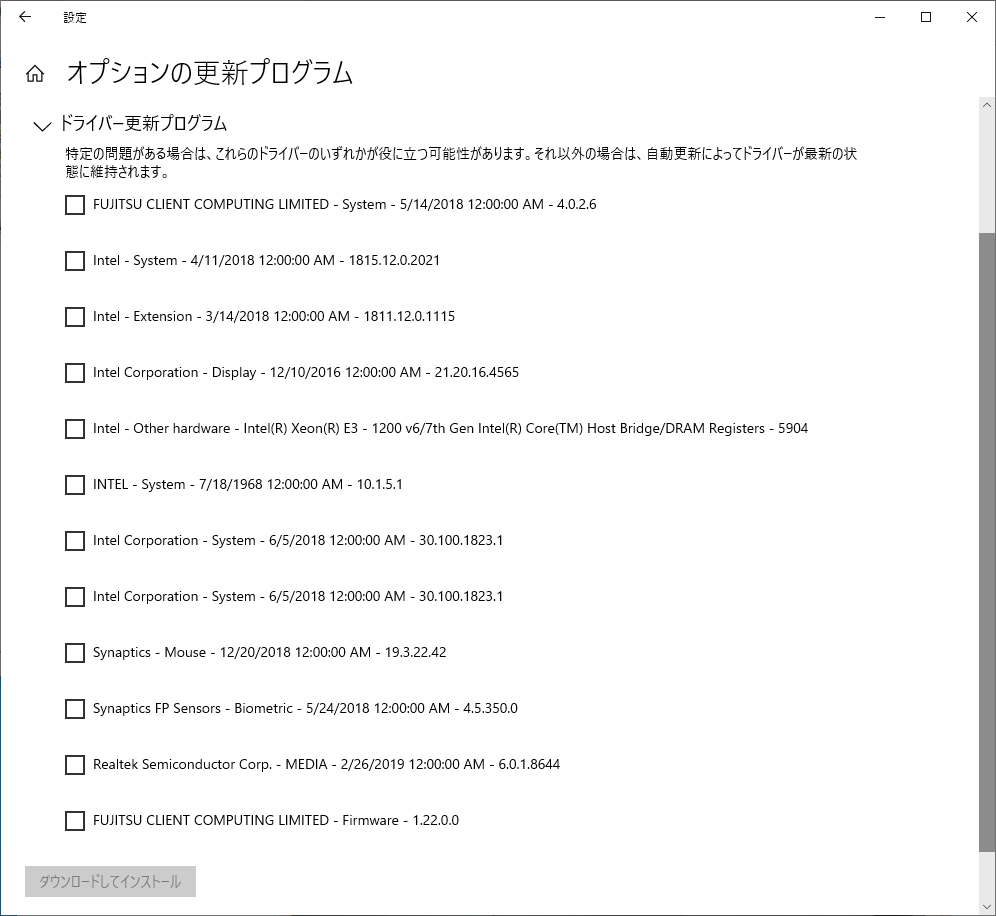

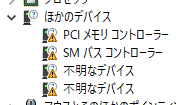

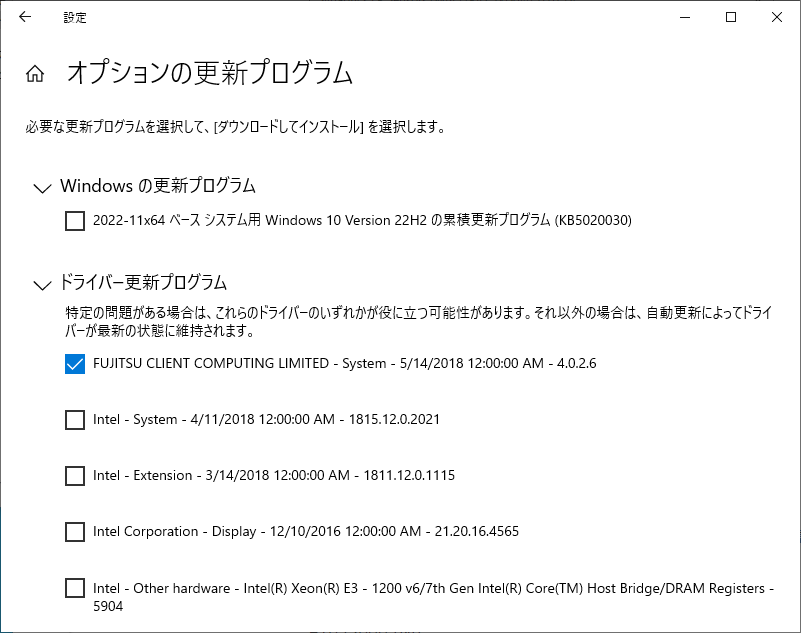

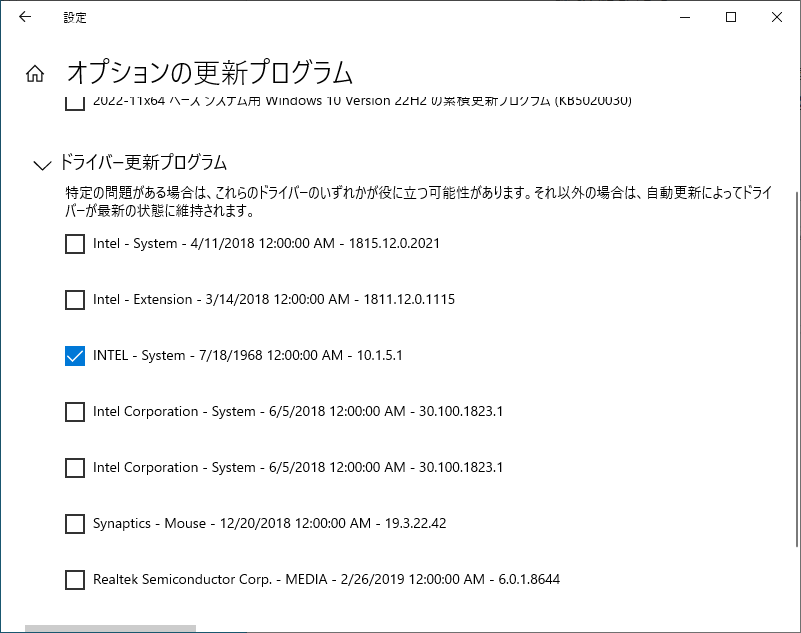

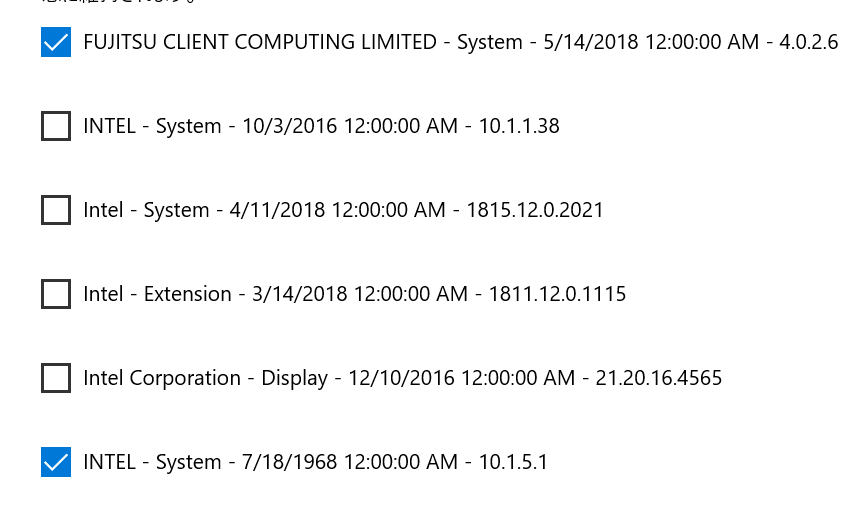

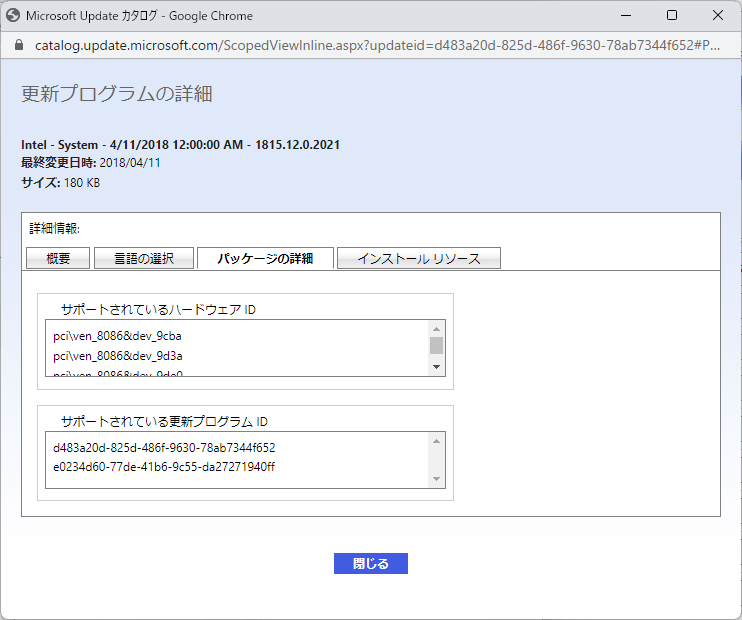

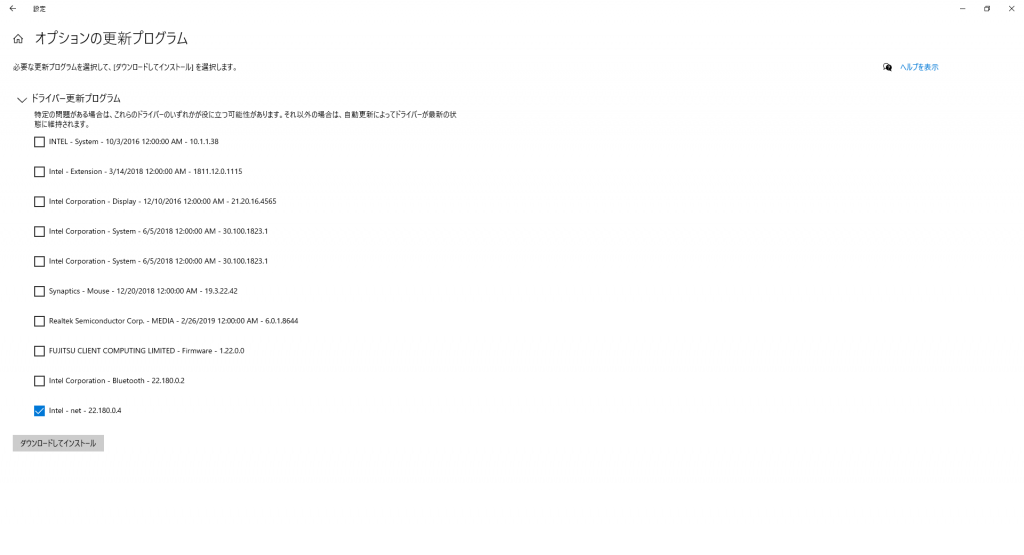

Windows Updateからオプションの更新プログラムを表示すると下記の様な感じでドライバー更新プログラムがあります。

ここから、以下を選択すると、不明なデバイスが認識し、MU937のBIOSも2022年8月リリースのものに更新されます。

・FUJITSU CLIENT COMPUTING LIMITED – System 5/14/2018 12:00:00AM – 4.0.2.6

・Intel – System – 4/11/2018 12:00:00 AM – 1815.12.0.2021

・INTEL – System 7/18/1968 12:00:00 AM – 10.1.5.1

・Synaptics FP Sensors – Biometric – 5/24/2018 12:00:00 AM – 4.5.350.0

・FUJITSU CLIENT COMPUTING LIMITED Fimware – 1.22.0.0

特にメーカページなどからデバイスドライバーをダウンロードしてくる必要はありませんでした。

以下にあるのはいろいろやってみた時の記録です。

Windows 10インストール実践

LIFEBOOK S937/Rインストールの経験から、以下が重要だろうとピックアップ

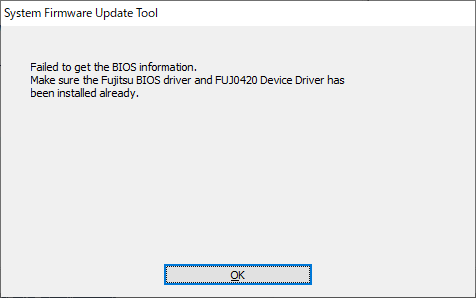

LIFEBOOK UH90/B1,UH75/B1,WU2/B1,FUTRO MU937用BIOS書換データ E1033761.exe

コントローラー用ファームウェア修正プログラム E1024123.exe

インテル(R) ディスプレイドライバー 64ビット版 E1026975.exe

インテル(R) マネージメント エンジン インターフェイス ドライバー E1024939.exe

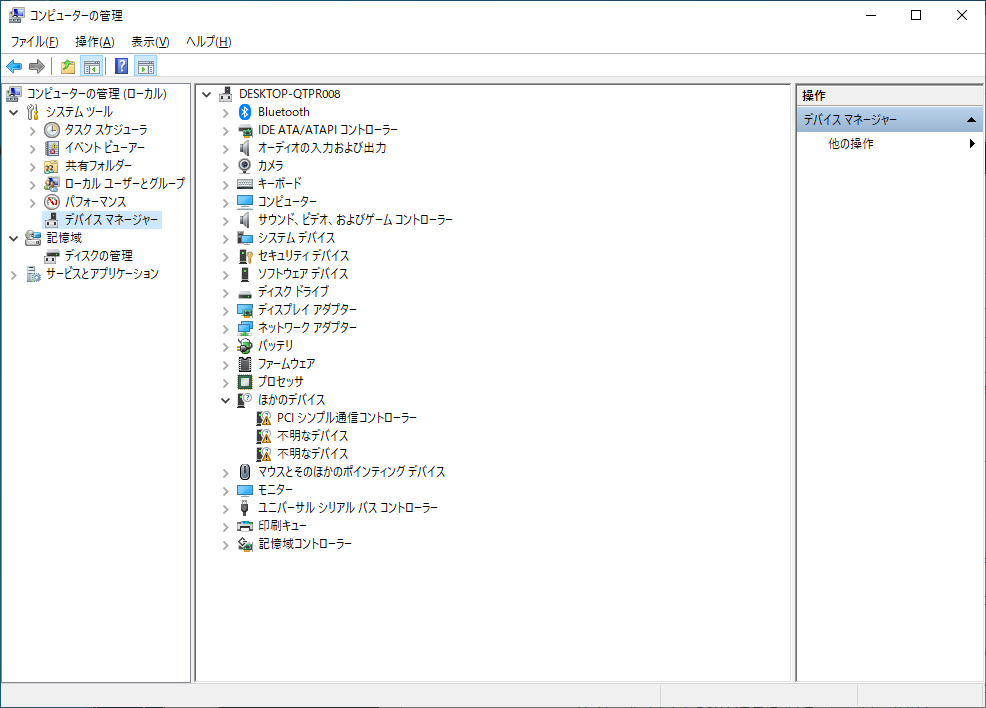

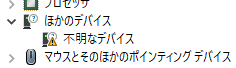

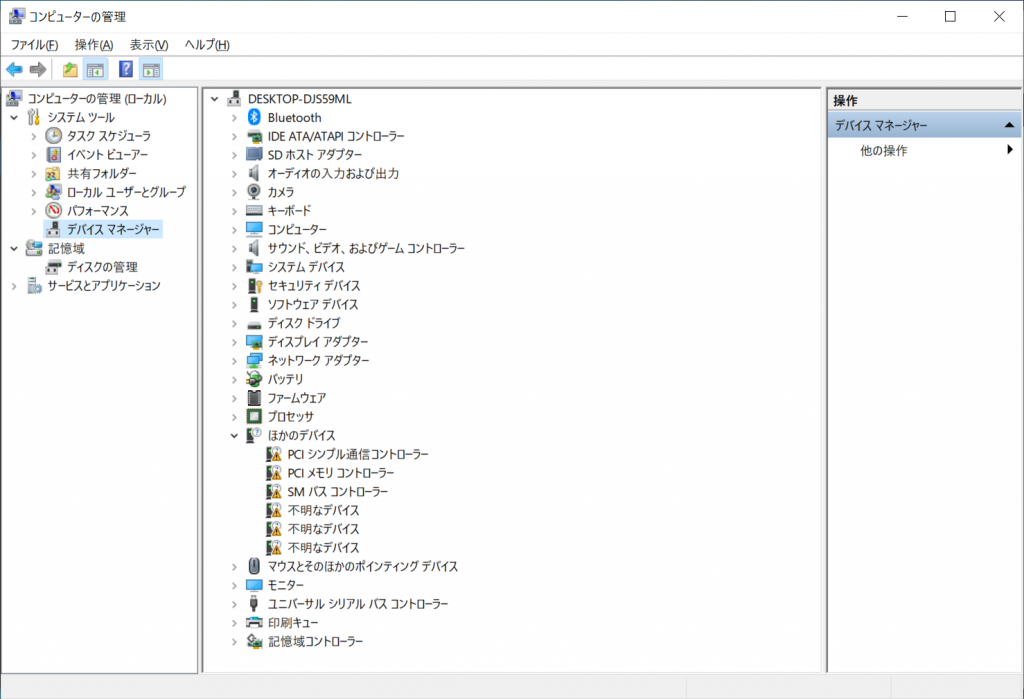

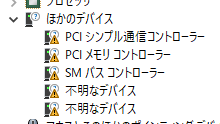

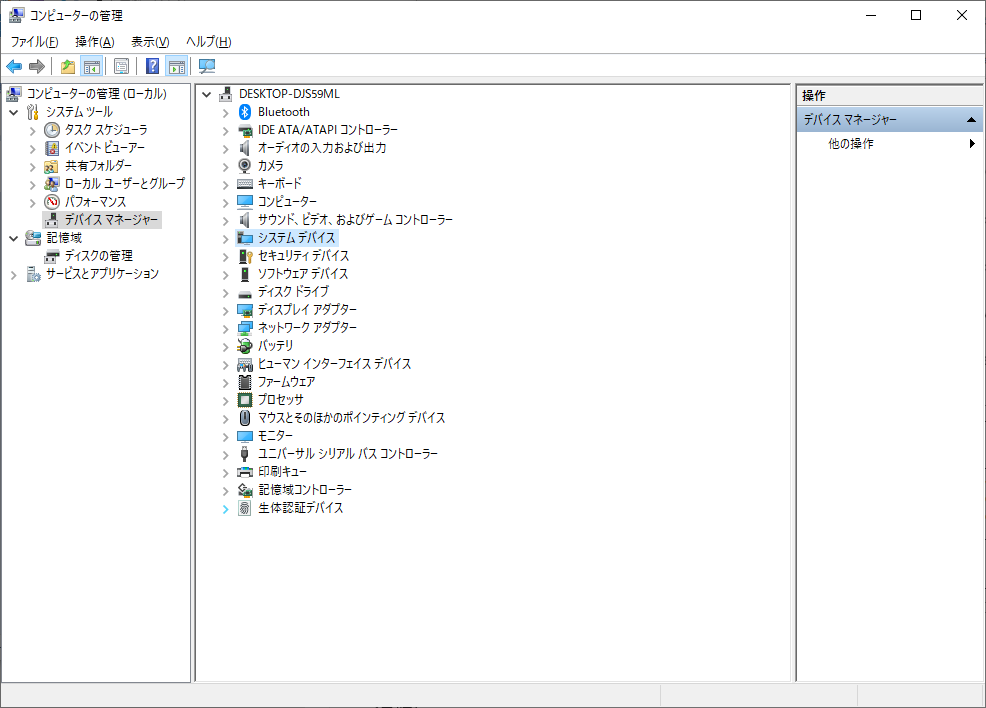

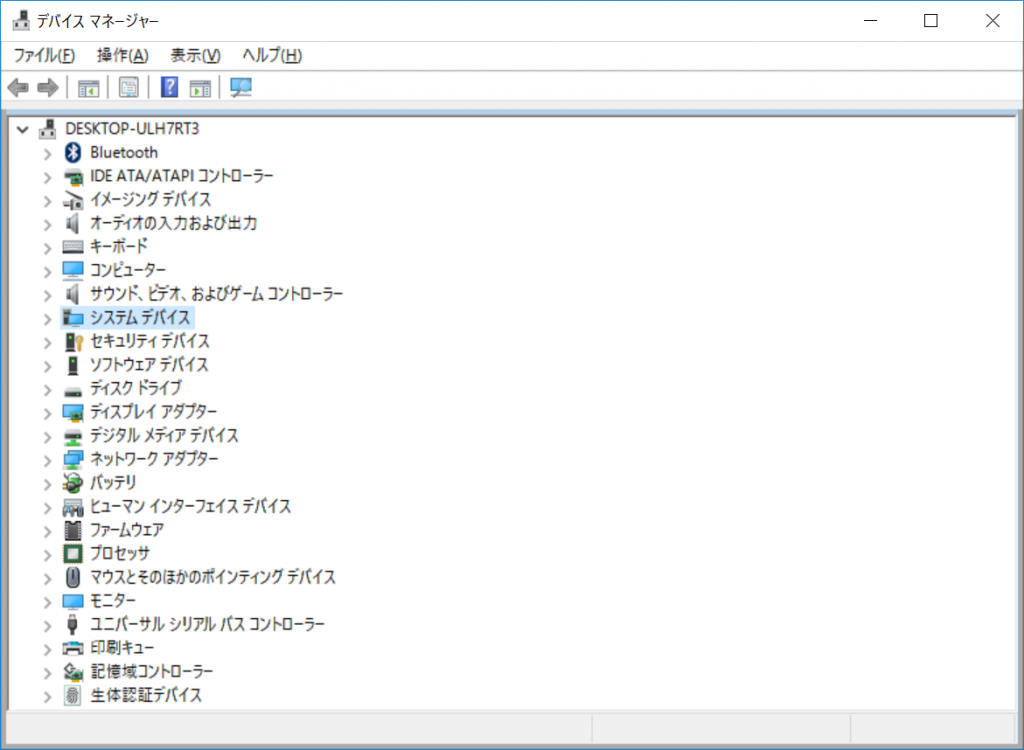

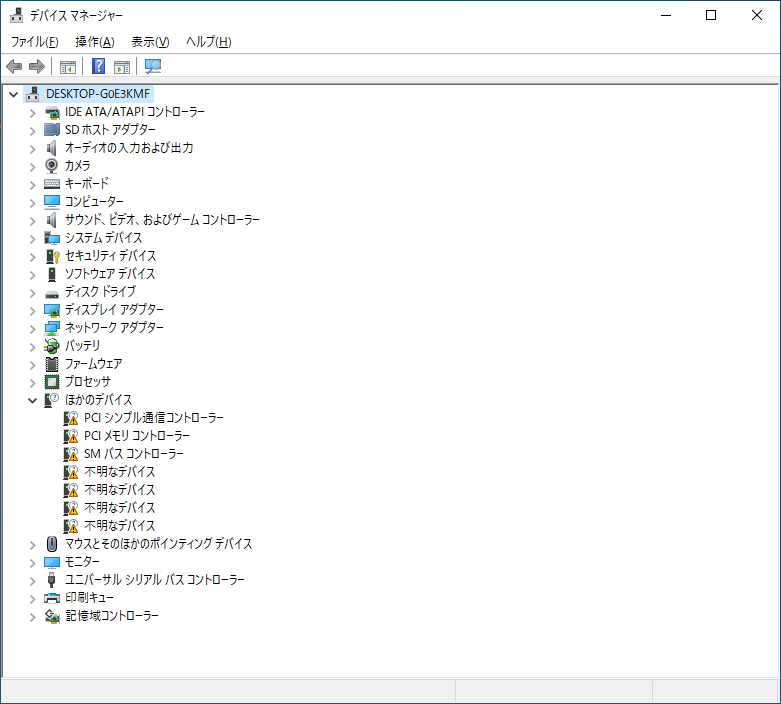

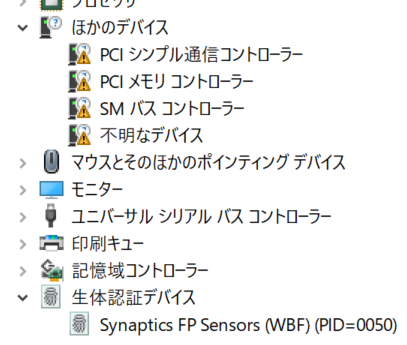

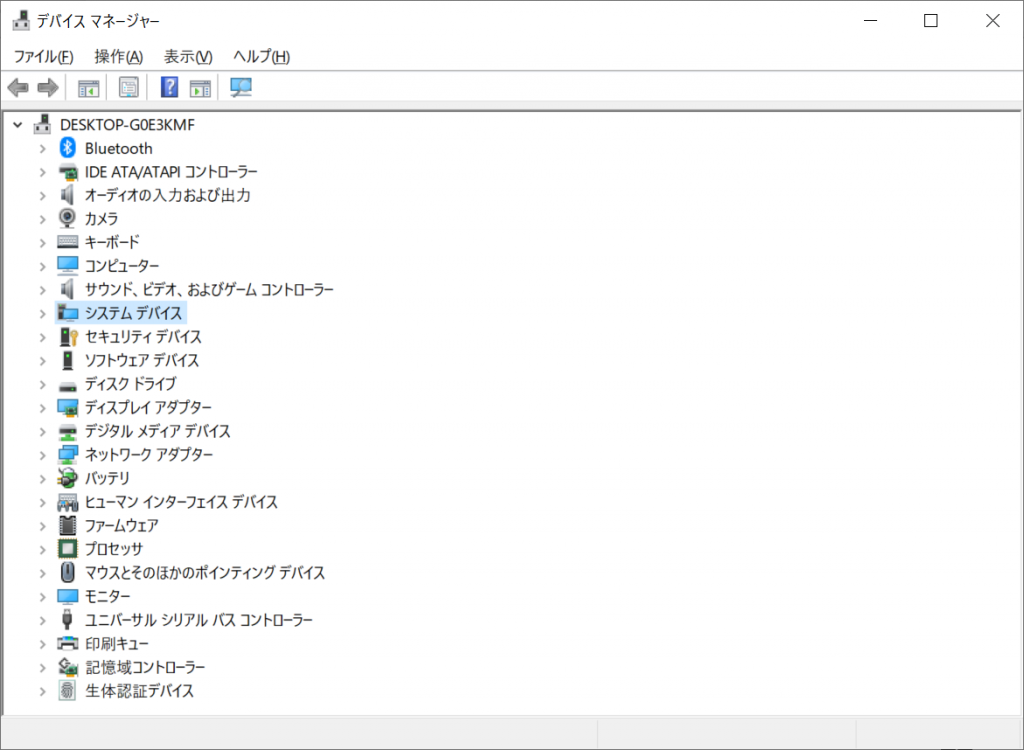

まずは普通にWindows 10 22H2をインストールしてみると下記のデバイス認識状況

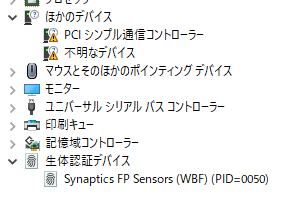

一通りWinodws Updateを適用したあとのデバイスマネージャー

変わらなかった

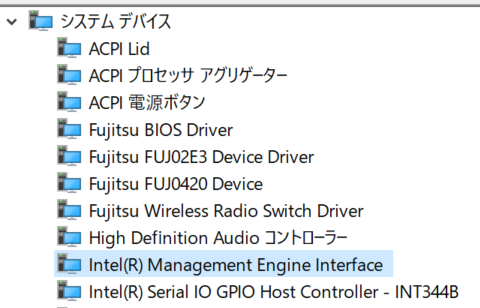

インテル(R) マネージメント エンジン インターフェイス ドライバーで1つ認識

インテル(R) ディスプレイドライバー 64ビット版インストールでは変化せず

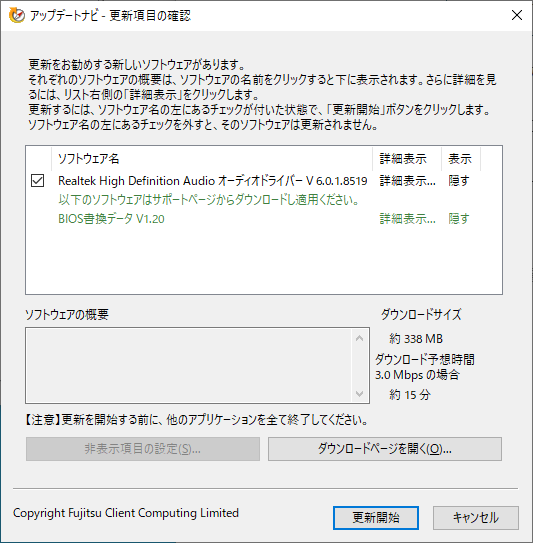

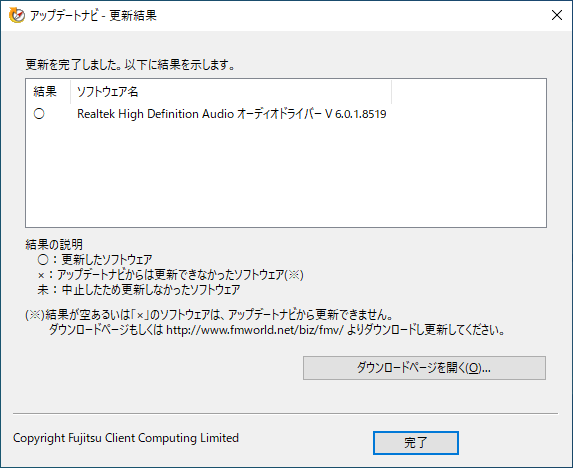

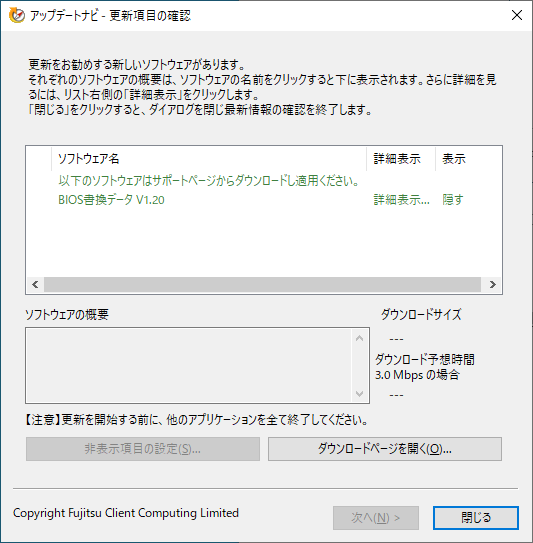

Windows Updateのオプション更新プログラムを確認

一番下のFUJITSU CLIENT COMPUTING LIMITED Fimware – 1.22.0.0 を適用

適用&再起動後にBIOS画面に入ってみると、1.22にアップデートされていることを確認

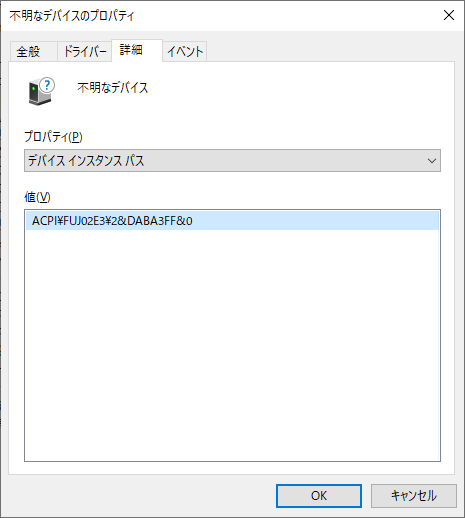

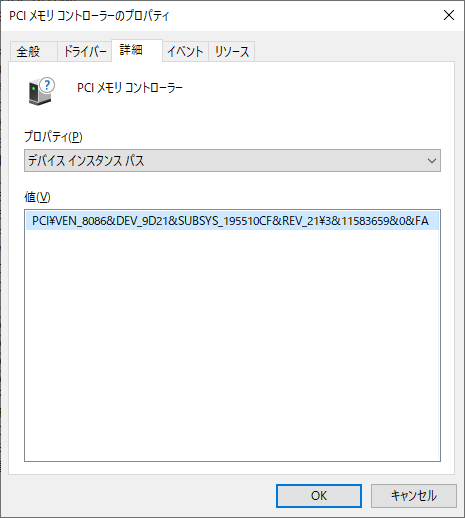

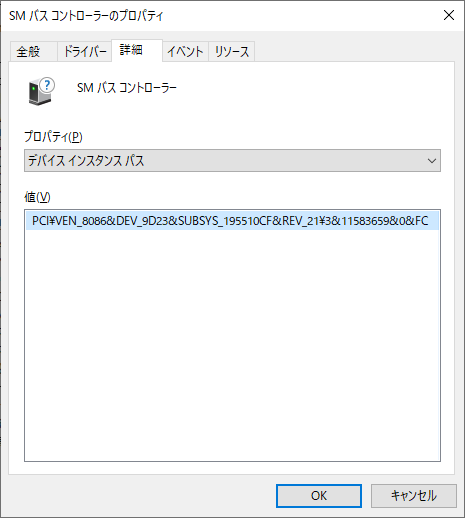

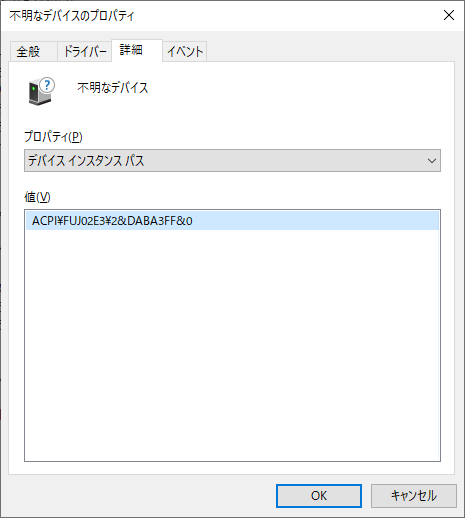

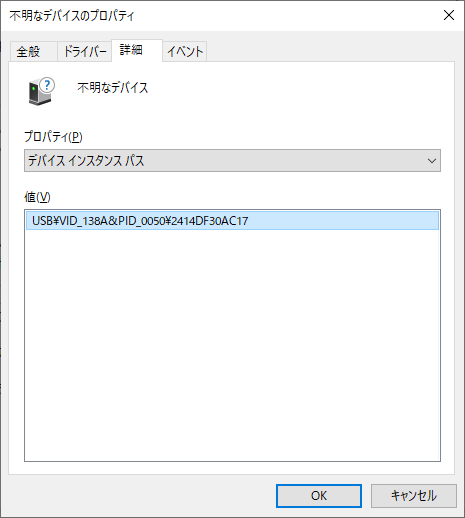

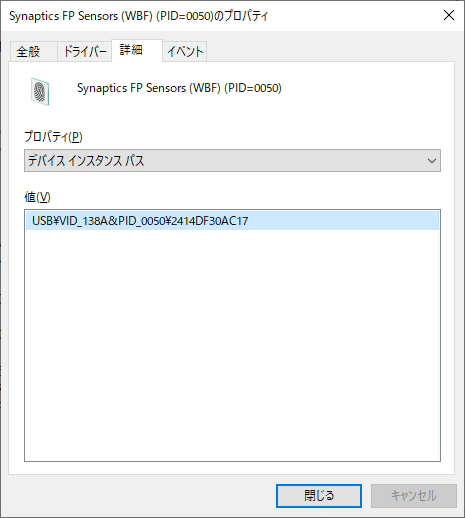

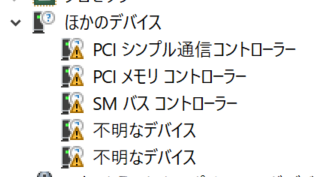

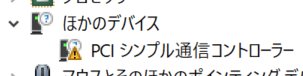

続いてドライバが正常に適用できていないデバイスの詳細を確認

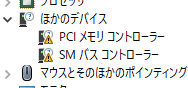

PCIメモリコントローラー VEN=8086, DEV=9D21

SMバス コントローラー VEN=8086. DEV=9D23

不明なデバイス ACPI\FUJ02E3\2&DABA3FF&0

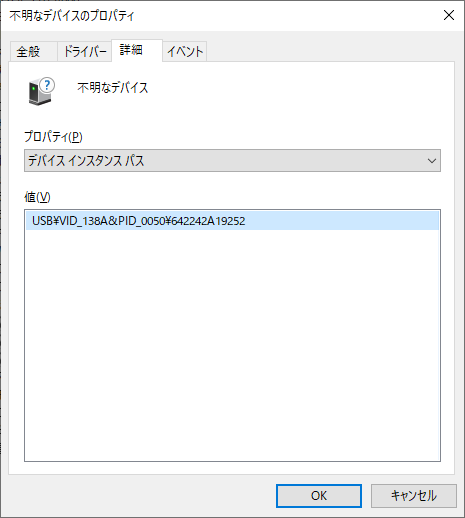

不明なデバイス VID=138A&PID=0050

さて、LIFEBOOKのドライバと同じものがあります

まず、「不明なデバイス VID=138A&PID=0050」は指紋認識、Validity WBF 指紋センサードライバー E1029594.exe です。

無事認識

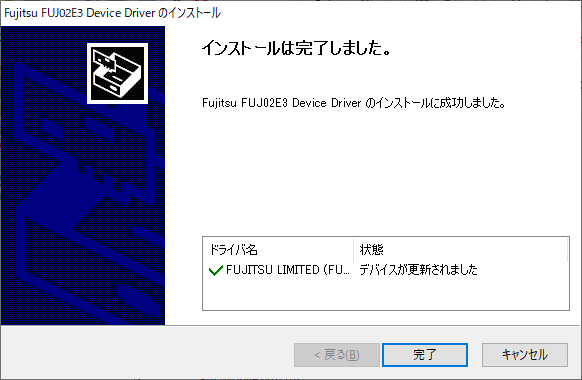

「不明なデバイス ACPI\FUJ02E3\2&DABA3FF&0」はLifebookの時はいろいろ試行錯誤してみたものの、もしかしてWindows Updateで適用できるのでは?と感じたので「FUJITSU CLIENT COMPUTING LIMITED SYSTEM 5/14/2018 12:00:00 – 4.0.2.6 」をインストールしてみると・・・

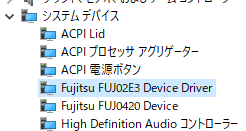

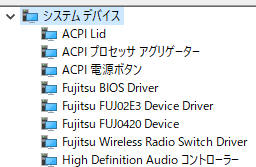

見事にドライバが適用され「Fujitsu FUJ023 Device Driver」と「Fujitsu FUJ0420 Device」を認識した

残るは2つ。こちらはLifebookだと自動的に適用されたものになる。

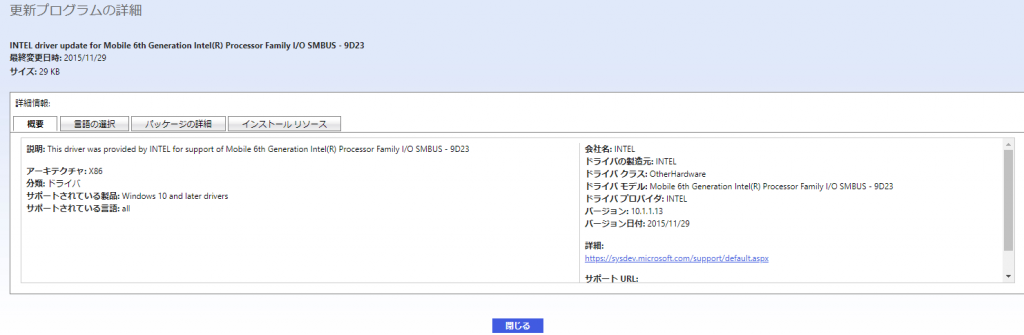

SMバスコントローラのデバイスIDで検索するとMicrosoft Updateカタログの「INTEL driver update for Mobile 6th Generation Intel(R) Processor Family I/O SMBUS – 9D23」が出てきた

Windows Updateのオプション更新の一覧に「INTEL SYSTEM 7/18/19 – 10.1.5.1」と上記カタログのバージョン10.1.1.13と似たものがあるのて適用してみる…

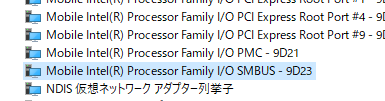

残っていた2つとも「Mobile Intel Processor Family I/O PMC – 9D21」と「Mobile Intel Processor Family I/O SMBUS – 9D23」として認識された

これで全てのデバイスが認識できた。

音量問題

しばらく使って見ると本体スピーカーから出力される音量が極端に小さいことに気がついた。

イヤフォン端子からだと特に問題はない。

ドライバの調整の問題なのかな、とLifebookで適用した Realtek High Definition Audio オーディオドライバーE1027123.exe をインストールしてみたが、状況は変わらなかった。

さらによく分からないのが、FUTRO MU937から他のWindows 11 Proパソコンにリモートデスクトップ接続して、他のパソコン側で音を再生した場合は正常にスピーカーから出力されるという状況。

うーん???

この現象、インストールしなおしたら再現しなくなったので結局謎でした。

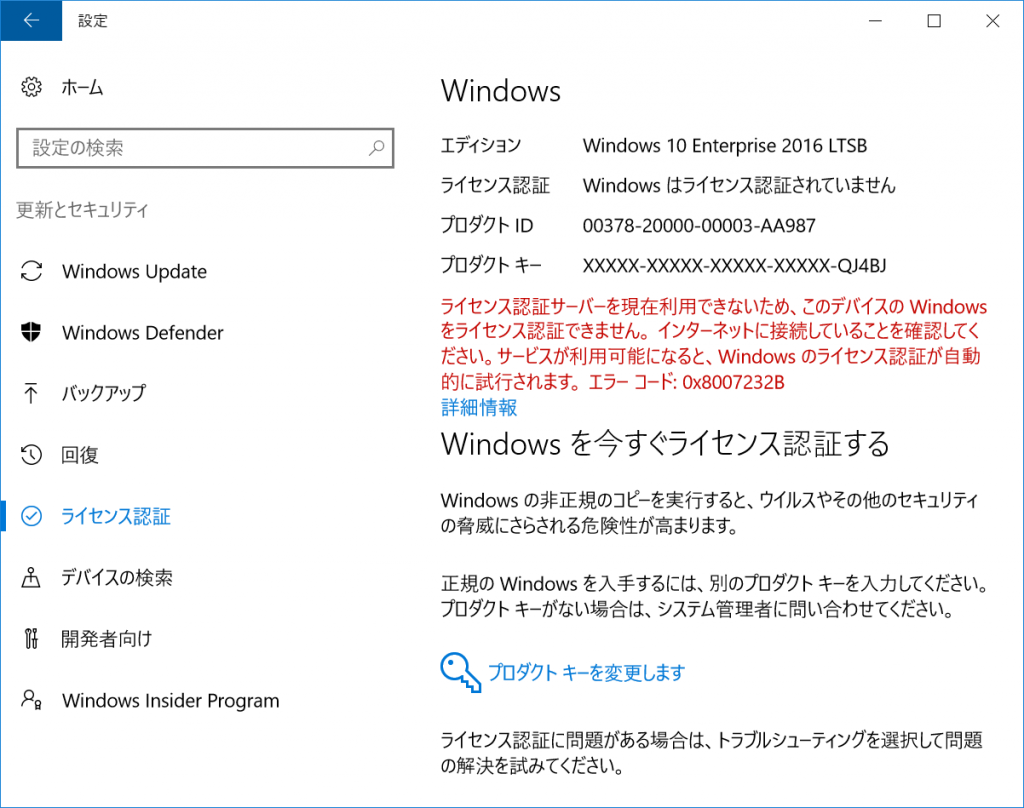

Windowsのライセンスについて

MU937で標準インストールのWindows 10 IoT Enterprise 2015 LTSBのサポートは2025年10月まで

Windows 10 IoT Enterprise 2015 LTSBのライセンスキーは普通のWindows 10のライセンスキーとは別扱いのため、普通のWinodws10をインストールしてもライセンス認証状態にはならない。

なお、Windows 10 IoT Enterpriseというのはシンクライアント専用の機能限定版Windowsで、ユーザ側でアプリの追加などが難しい、という仕組みになっている。

詳細についてはVAIOのページにある「Windows 10 IoT Enterpriseと通常版の違い、導入の注意点は?」がまとまっていて分かりやすい。

結局のところ、一般人にはWindows 10 IoT Enterpriseのインストールメディアは入手できない、と

なので、継続して利用しようという場合は、別途Windows 10ライセンスを入手する必要があります。

Windows 10 Enterprise 2016 LTSB

Windows 10 Enterprise 2016 LTSBのメディアがあったのでインストールしてみた

まあ、Windows 10 IoT Enterprise L2015 LTSBとは別枠でしたね。

興味深いのはインストール直後はデバイスマネージャーに7個ぐらい警告があるデバイスが表示されていたのですが、Windows Updateを実行してみると下記のようにすべてのデバイスが認識されたという・・・

最近のWindows 10 22H2だと認識しなくなっている、というのが若干謎である。

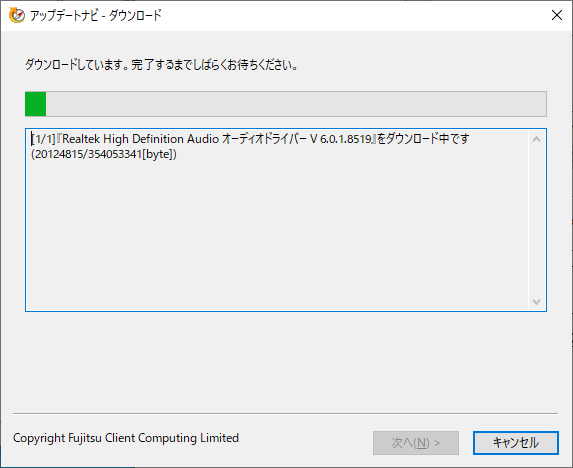

Windows 10 Home 22H2

Windows 10 Enterprise 2016 LTSBではライセンスが通らなかったので、Windows 10 Homeライセンスを調達するために、再インストール。

ネットワークにつながない状態でデバイスマネージャー確認

Windows Update後は以下の認識になった

この間と同じものですね

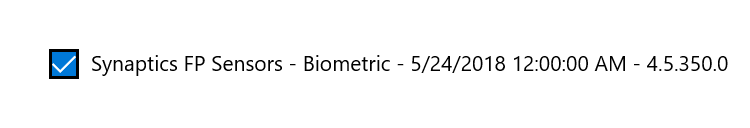

今回はWindows Update経由で指紋認証デバイスが認識できないかを確認

「Synaptics FP Sensors – Biometric – 5/24/2018 12:00:00 AM – 4.5.350.0」をインストールしてみる

指紋認証デバイスが認識しました。

続いて「FUJITSU CLIENT COMPUTING LIMITED – System 5/14/2018 12:00:00AM – 4.0.2.6」と「INTEL – System 7/18/1968 12:00:00 AM – 10.1.5.1」を適用

ここで再起動必須

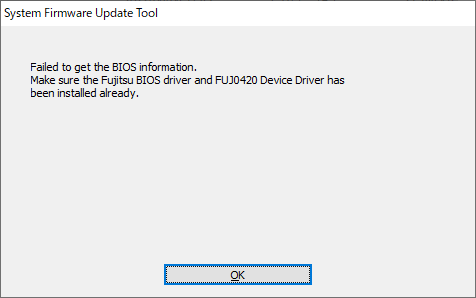

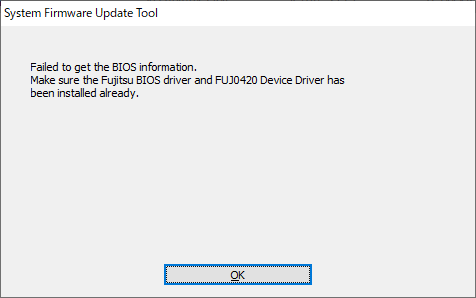

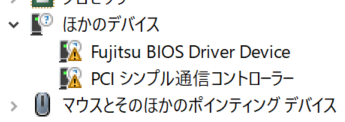

あれ?Fujitsu BIOS Driver Device残ってるの?

と思ってたらしばらく経つとなくなった

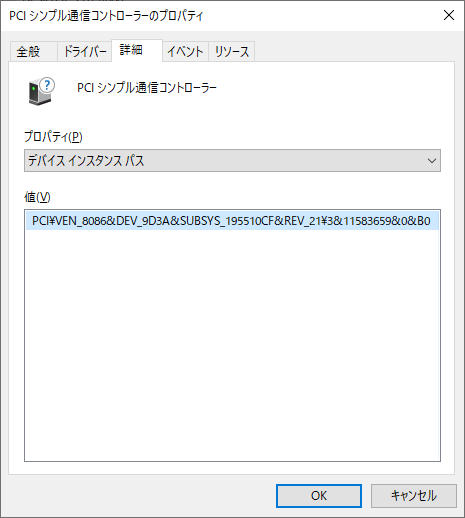

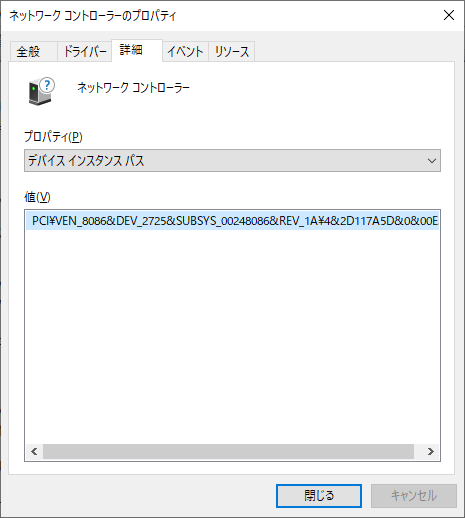

最後のデバイスはインテルマネージメントインタフェースドライバ「VEN=8086, DEV=9D3A」でした。

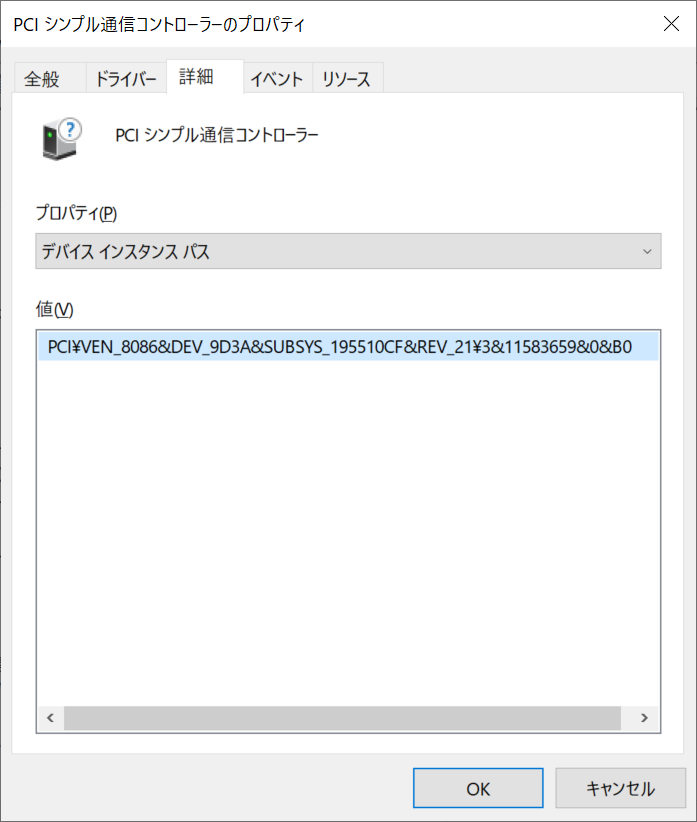

Windows Updateにある「Intel – System – 4/11/2018 12:00:00 AM – 1815.12.0.2021」が怪しいけど、詳細が分からないなー、とMicrosoft Updateで「Intel Management Engine Driver 1815」と検索してみると「Intel – System – 4/11/2018 12:00:00 AM – 1815.12.0.2021」が出てきた。

パッケージの詳細にある「サポートされているハードウェアID」を確認すると、「VEN=8086, DEV=9D3A」がある。

というわけで、Windows Updateから「Intel – System – 4/11/2018 12:00:00 AM – 1815.12.0.2021」をインストールしてみる

無事、認識しました。

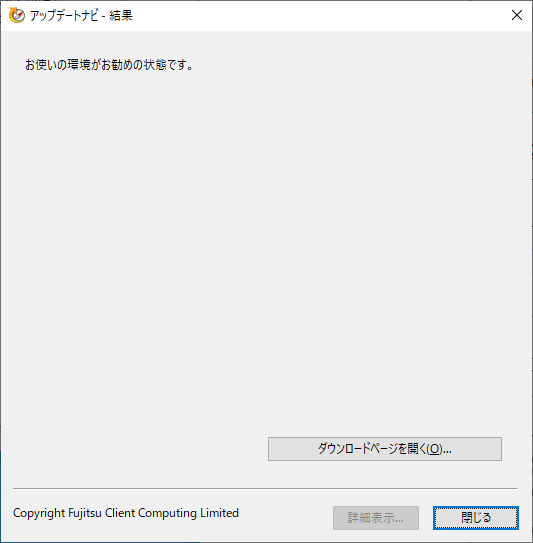

というわけで、Windows Updateだけでもドライバが適用できました。

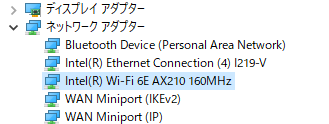

WiFi交換

802.11axにるためIntel AX210NGWに交換してみた

裏蓋を開けて交換

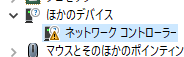

交換後、Windows Upateで認識するかなー、と思ったけど、△マークのまま

Microsoft Updateカタログで「Intel net dev_2725」と検索してでてくる「Intel – net – 22.170.2.1」のサポートされているハードウェアIDは「pci\ven_8086&dev_2725&subsys_40208086」なので行けそう。

Windows Updateのオプション更新プログラムにある「Intel – net – 22.180.0.4」が似てるかなー、ということでインストール

無事に「Intel(R) Wi-Fi 6E AX210 160MHz」として認識

M.2 SATA増設した

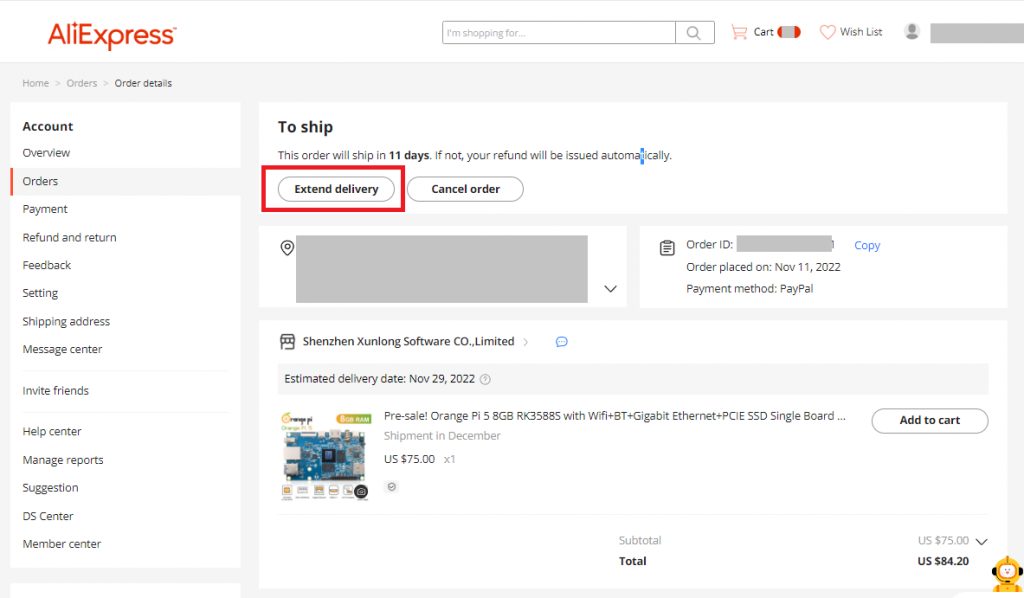

日本で2242サイズのM.2 SATAを探したら高かったので、aliexpressで安いやつを買ってみた

KingSpec M.2 SATA 512GB $30.04

GUDGA M.2 SATA 512GB $28.20

12月10日に別のセラーにそれぞれ発注入れたら、どちらもAliexpress Standard Shipping→クロネコ配送で12月17日に到着しました。

同じ基板を使ってるのかな?と思ったのですが、違う感じ

FUTRO MU937に増設

まあ、普通に使えてますね