2025/06/04追記

Buurst社 SoftNASは現状も継続はしている模様

ドキュメント や これまでのリリースノート が自社Webからatlassianのサービス上に変わっていた。

2021年11月リリースのSoftNAS 5.2.0でCentOS 8.4ベースからRocky Linux 8.5ベースに切り替わっていた。

2025年3月にSoftNAS 5.6.3がリリースされているがBug FixにあるRLSA-2025:1068とRLSA-2025:1266はRocky Linux 8.に対する修正なので、Rocky Linux 8.xベースの更新であるようだ。

ドキュメント流し読みしてたら「Keeping the same UIDs/GIDs across SoftNAS and Linux Clients」というページが・・・sssdを使ってActive Directoryに参加する、という話なのだが

Linuxクライアント側と、NFSサーバ(SoftNAS)側の双方でどういうコマンドを実行して確認するか、という例が書いてあってわかりやすい

2021/02/10追記

2020/04/21にSoftNAS社はBuurst社となっていた(Learn the new rules of cloud storage)。

プロダクトとしては引き続きSoftNASという名称のままである。

2021年1月にCentOS8.2ベースにsamba 4.12を載せたSoftNAS 5がリリースされていた(Announcing SoftNAS 5 – a Modern Approach to Cloud NAS)。

これまでのリリースノート一覧やドキュメントなども見やすい形で公開されるようになっていた。

ただ、以前あったDeveloper Editionは消えて、Demo版がAWSかAzure上で展開できる、という形がメインになっている模様で、ローカルのvSphere上で展開する用のファイル提供の入手は面倒になっているようだ。

2019/01/23追記

2019年1月現在、SoftNAS Essentialsは有償プランの1つとなり、無償で使えるものは「SoftNAS Developer Edition」となった。使用可能容量も250GBまでと大きく制限されている。Amazon AWS, Microsoft Azureのマーケットプレイスにイメージが並んでいるので、そこからデプロイできる他、スタンドアローンのvSphere上にデプロイするためにSoftNAS-4.0.1.ovaが提供されている。

以下は2013年3月記載の古い記述となります。

SoftNASというものがあるらしい。

・CentOS6ベース

・ファイルシステムはZFS

・vSphereやHyper-Vの上に仮想マシンとして動作させる

・Amazon EC2用も用意されている

・検証用にVMware Workstation 8.xもサポート

・割り当てるCPUリソースは2vCPU~8vCPU

・割り当てるメモリリソースは2GB~32GB

・Dedupe機能あり(1TBにつきメインメモリ1GB追加使用)

・Thinprovisionおよび圧縮

・NFS/CIFS/iSCSIを提供できる

・Volumeスナップショット

・レプリケーション機能あり

→ Amazon EC2上に立てたサーバにレプリケーションできる

・ZFS L2ARCを利用したSSD利用の高速化

「SoftNAS Essentials」という機能限定版は無償利用可能。

限定の内容の抜粋

・1TBまで

・以下の機能が使えない

・SSD利用の高速化

・iSCSI機能

・レプリケーション

・スナップショットのスケジューリング

詳細の違い

まぁ、おもしろそうではあるので、ちょっと試しに使ってみるかな

インストールしてみた

・CentOS 6.3 x86_64

・kernelはCentOS標準を利用している

・ZFS on Linux利用

zfs-0.6.0-rc14.x86_64, zfs-modules-dkms,zfs-dracut,zfs-test

・独自Web GUI+Webmin

・NFSやCIFS設定はWebmin画面という感じ

・独自Web GUIは、iconCubeを使って暗号化処理をおこなっている

・独自Web GUIは多言語対応を考慮に入れてないっぽい

・LinuxはGUIログイン

・Chromeインストール&yum repo登録済

・sysctlに特にコレといったパラメータが入れられてない

・/etc/sysconfig/nfsとか/etc/init.d/nfsにも特にパラメータが入ってない

・「Software Updates」は、あくまでSoftNASに関するモジュールのみで、CentOS自体のアップデートは対象外

微妙だなぁ、と感じた、もっとも大きな点は、管理UIの不徹底です。

新規で使う際、以下の順序で操作をおこなっていきます。

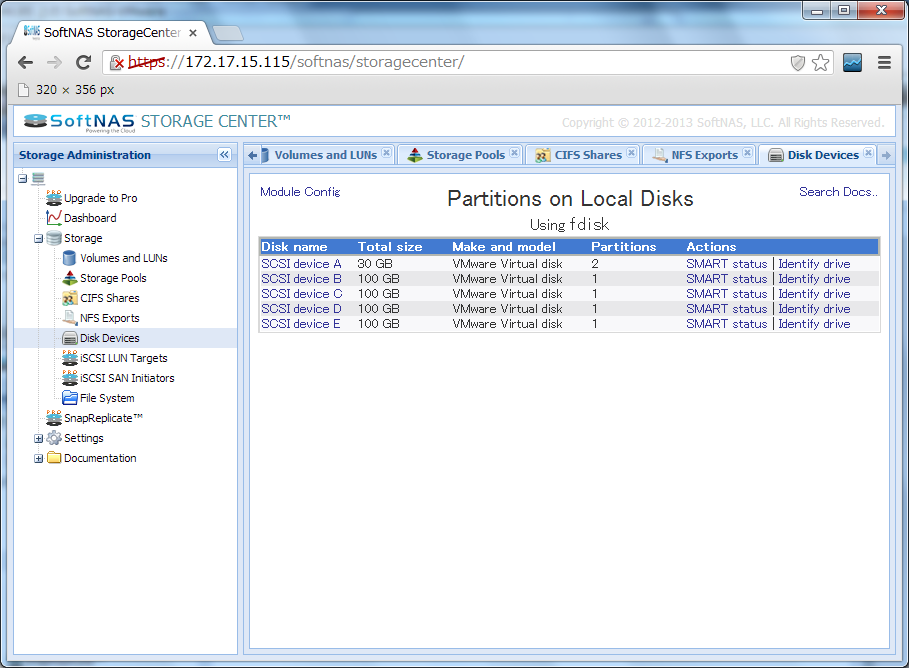

2. 「Disk Devices」にて空きディスクにパーテーション設定

この画面はWebminそのままです。

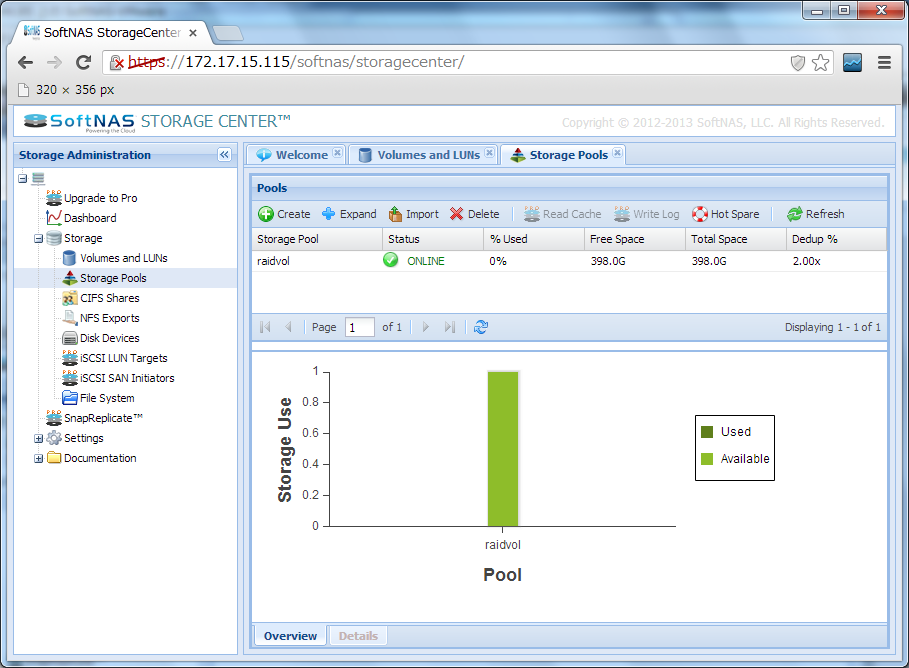

3. 「Storage Pools」にてディスクの登録

独自のAJAXなUIです。

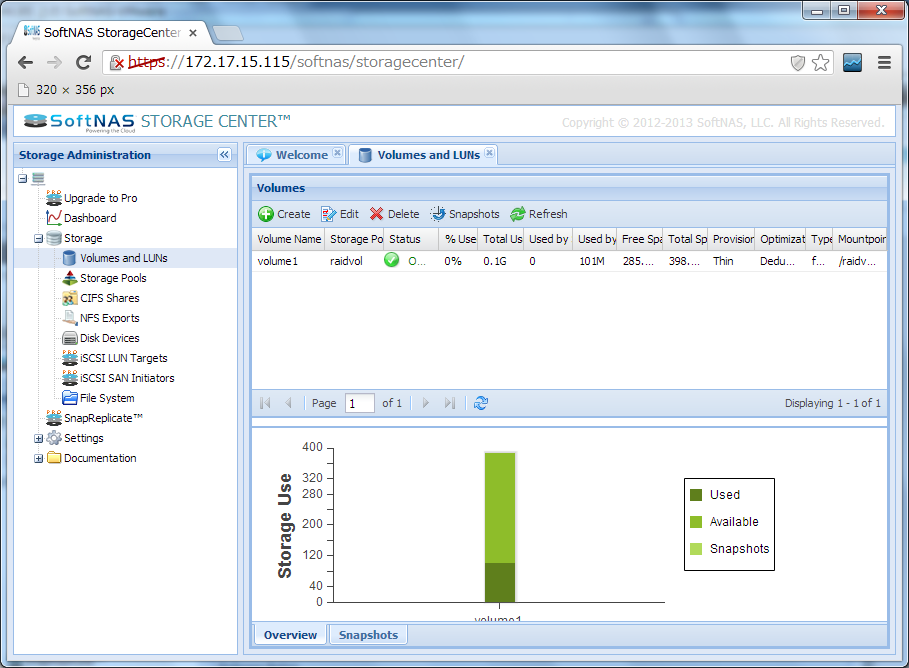

4. 「Volumes and LUNs」にてボリューム作成

独自のAJAXなUIです。

ここでボリュームを作成すると、マウントされるようになります。

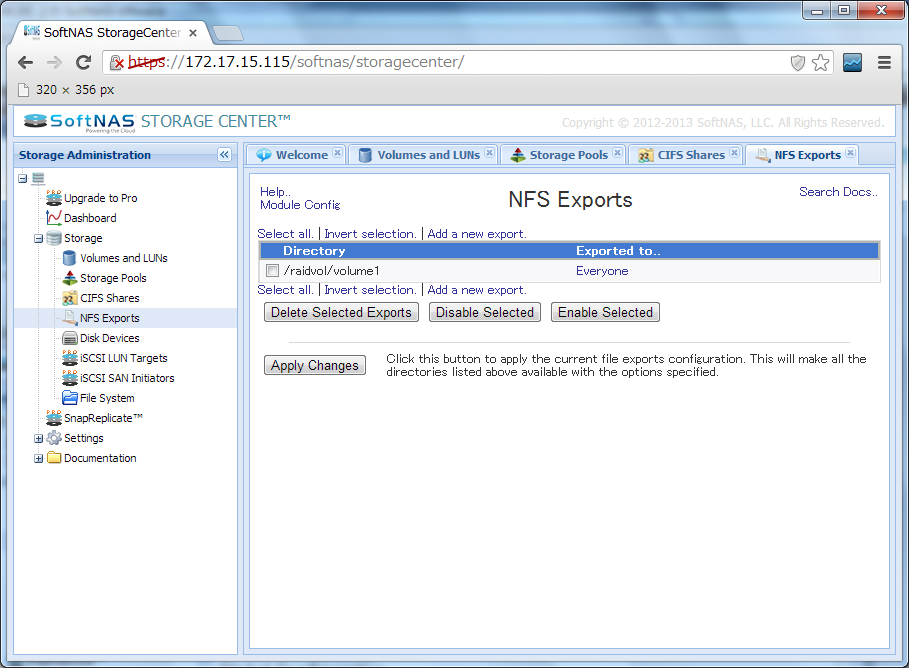

5. 「NFS Exports」にてNFSマウントの設定

この画面はWebminそのままです。

NFSv4対応のwebmin設定画面はPseudofilesystemの関連でちょっとわかりにくいのですが、放置です。

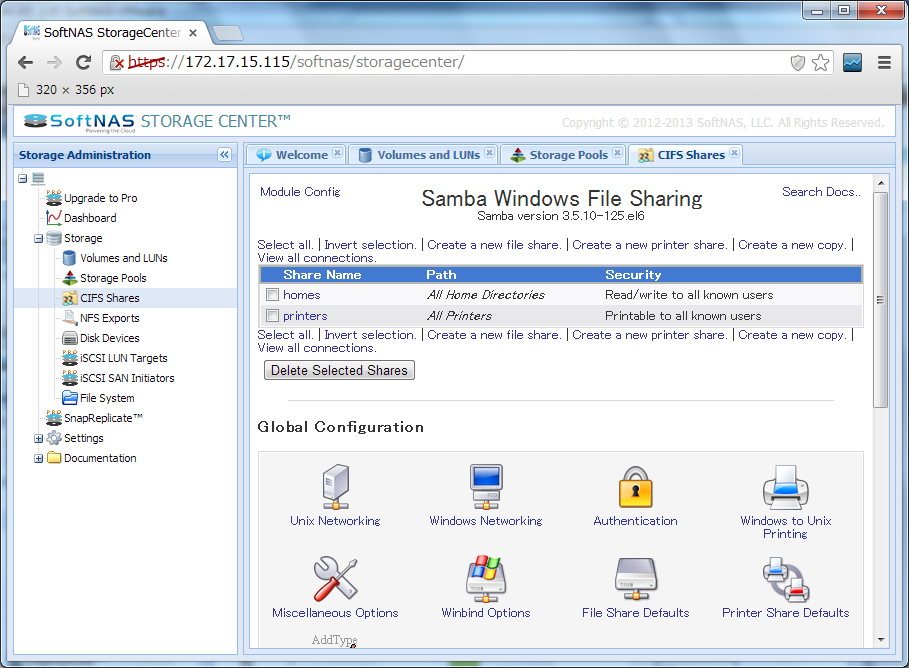

6. 「CIFS Shares」にてCIFS関連設定

この画面もWebminそのままです。

なお、説明書を見ると、CIFS設定は、別途コマンドおよびファイル編集が必要、と書いてあります。

というわけで、使いやすそうな雰囲気がするGUIのわりに、手を抜いてる場所が結構あるせいで、操作感の統一がされておらず、説明も足りてないので、非常に使いにくい感じになっています。

はたして、これは修正されていくのでしょうか・・・???