会社で使うためのサポートありでNAS OS単品で入手できそうなところを調べてみた。

なお、WindowsStorageServerは除外しています。

2023/11/14: 微修正

iXsystem社 TrueNAS

FreeBSDベースのNAS OSとしてTrueNASとFreeNASがあったが、2020年3月に統合され、TrueNAS CoreとTrueNAS Enterpriseになった。

2020年7月から Linux OSベースのTrueNAS SCALEの開発が始まった。

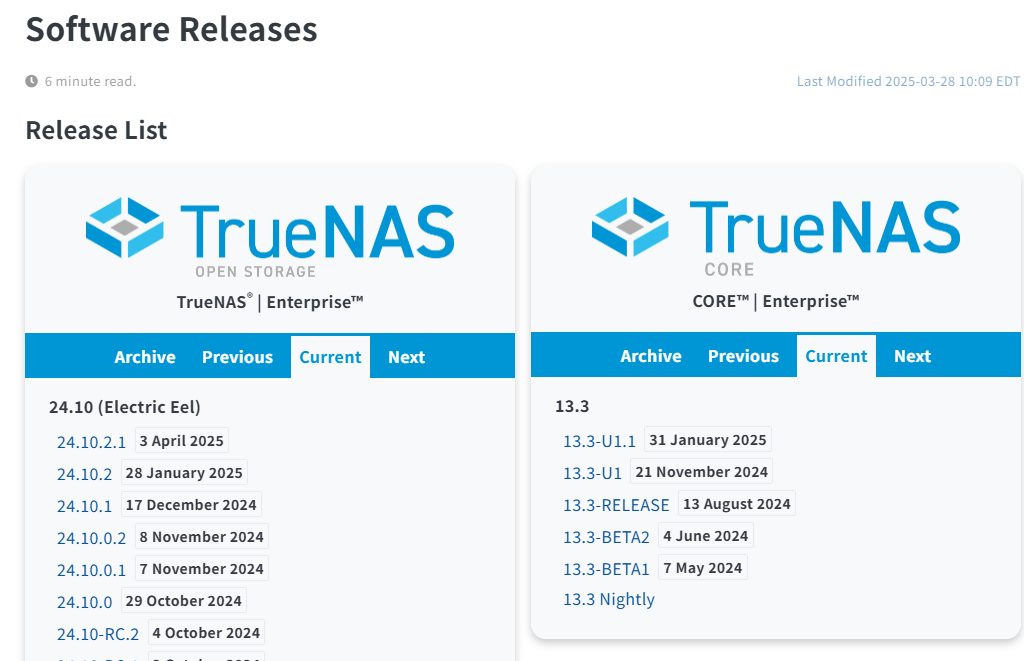

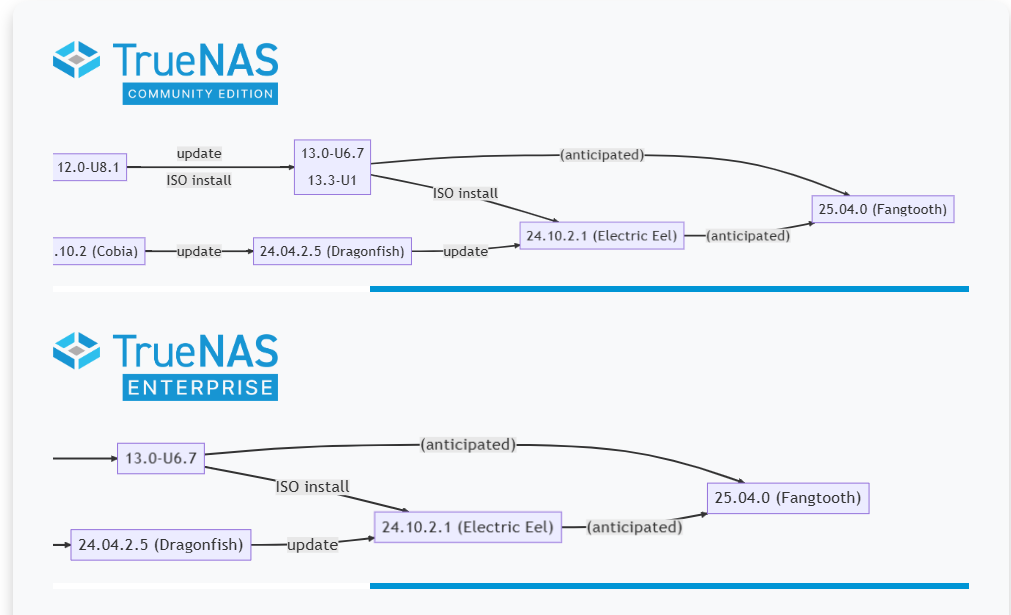

現在は「TureNAS Enterprise」「TrueNAS Community Edition(TrueNAS SCALE)」「TrueNAS Legacy (TrueNAS CORE / FreeNAS )」という形になっているようだ。

・TrueNAS SCALE 製品ページ TrueNAS CORE製品ページ TrueNAS Community Edition 製品ページ TrueNASのgithub

製品バージョン

iXsystems社 TrueNAS / FreeNAS

以前は別ラインだったTrueNAS とFreeNAS は2020年3月に統合が発表され、TrueNAS CORE (旧FreeNAS)とTrueNAS Enterprise になっていくことになりました。

商用向けは、TrueNAS Enterpriseになる。

ベースOS: FreeBSD?

なお、TrueNAS SCALE というLinuxベースのものもgithubにて開発中 。OpenZFSとGlusterを組み合わせたスケールアウトとなっている。まだ全体を置き換える感じではない模様。

ドキュメント類TrueNAS CORE 13.0 TrueNAS SCALE 22.12(Bluefin) , TrueNAS SCALE 23.10 (Cobia)

TrueNASのリリーススケジュール を見ると、TrueNAS COREの商用版がTrueNAS CORE Enterprise、TrueNAS SCALEの商用版がTrueNAS SCALE Enterpriseという扱いになるようだ。

DDN社 NexentaStor / NexentaStor VSA

いつの間にかストレージベンダのDDN社がNexenta を買収していた(2019年5月 DDN to Acquire Nexenta )。DDNは別のストレージベンダTintri社も買収しており、NexentaStor VSA for Tintri というコラボ商品もリリースしていた。

ソフトウェア商品としては「NexentaStor 」で、仮想環境上に載せるアプライアンスが「NexentaStor Virtual Appliance(VSA)」という商品名になっている。

ベースOS:OpenSolaris

NexentaStorの技術情報は「https://nexenta.github.io/ 」で確認できる。

NexentaStor 5.5 and NexentaFusion 2.0 でリリースノートを見てみると、Tintri のロゴで始まっているので、Tinrti扱い?

NexentaStor 5.5は2022年12月リリースで、5.5FP2が2023年7月リリース、という形になっているようだ。

Open-E社 Open-E JovianDSS / Open-E DSS V7

相変わらずNAS OSの単品販売メインのOpen-E は2020年 2023年も健在。1998年創業なので25周年記念、とWebでうたっている。

旧来のOpen-E DSS V7 に加えて、ファイルシステムにzfsを採用したOpen-E JovianDSS が登場した。

ベースOS: Linuxベース

2023/11/14現在、OPEN-E DSS V7ページにはあと約1年で製品終了、と記載されるようになり、Open-E JovianDSSのみが継続しているようだ。

Open-E JovianDSSは標準価格が明記 されていて分かりやすい。

StarWind社 StarWind Virtual SAN(VSAN)

StarWind社がStarWind Virtual SAN というのを公開している。

日本のclimb が取り扱っており「StarWind技術ブログ 」も公開している。

StarWind Virtual HCI Appliance (vHCI) という形でHyper-Vサーバ/ESXiサーバと組み合わせて使うタイプの製品も出ている

ベースOS: Linuxベース

OSNEXUS社 QuantaStor

OSNEXUS という会社が開発しているもの。

Community Editionは”1サーバあたり物理40TB”を4サーバまでで、2年間使えるライセンスが発行されるようだ。

ベースOS: Linux Ubuntu Serverベース

ドキュメント

XigmaNAS(NAS4Free)

元々2005年にFreeNASという名前で始まって、2011年にiXsystems社がFreeNASの商用を買収したことによりNAS4Freeに改名し、2018年から現状のXigmaNAS になっている。

価格をつけて販売しているわけではないので載せるか悩んだが、サーバ筐体などを売っているAspen Systems というところとjet stream でインストールしたサーバを販売しているようなので掲載。

資料サイト

ベースOS: FreeBSD

XigmaNAS 13.1.0.5 = FreeBSD 13.1

その他

CloudByte社 ElastiStorは、MayaData社(https://mayadata.io/)に移管後はプロダクトが見当たらないので消えた模様。githubアカウントはmayadataのやつ とcloudbyteの がある。cloudbytesの方は最終更新が2018年1月。2023/11/04現在mayadata.io にアクセスできなくなっていた。

RisingTide Systems RT OS はドメイン毎消滅。もともと情報が少なかったけど、その後は不明。

下記は2013年8月2日時点の情報を記録のため残しておく

・iXsystem TrueNAS Unified Storage FreeNAS の開発主体

・Nexenta NexentaStor

・RisingTide Systems RT OS RTS_OS を見ると、いろいろ詳細がある。マニュアル

・Open-E DSS V7

・StarWind iSCSI SAN & NAS V6

・OS NEXUS QUANTASTOR STORAGE APPLIANCE SOFTWARE マニュアル

・CloudByte ElastiStor