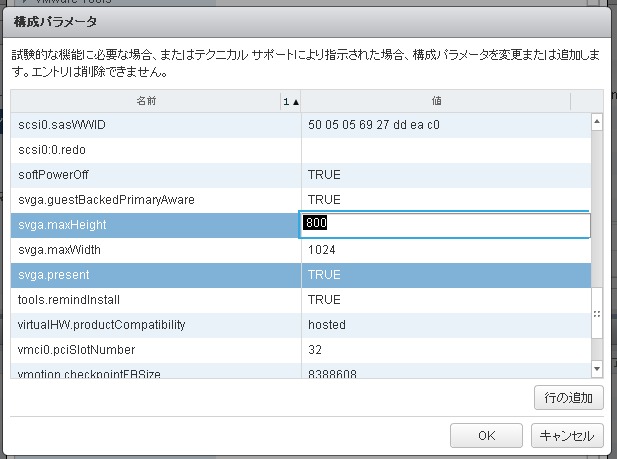

CentOS7環境でmuninを使ったら、文字化けっぽいものが・・・

何が原因なのかわからなかったので、とりあえず切り分けのために、以前作った「IIJmioクーポンスイッチAPIを使って使用量グラフ作成」のrrdtoolをCentOS7環境で実行してみた

rrdtool graph test-year.png --imgformat=PNG \

--height=300 \

--width=600 \

--lower-limit=0 \

--end now --start end-14months \

--vertical-label "MB" \

--x-grid WEEK:1:MONTH:1:MONTH:1:0:%m/%d \

--units-exponent 0 \

--title="IIJmioの1年分使用量" \

DEF:SIM1C=hdo~.rrd:withCoupon:LAST \

DEF:SIM1N=hdo~.rrd:withoutCoupon:LAST \

DEF:SIM2C=hdo~.rrd:withCoupon:LAST \

DEF:SIM2N=hdo~.rrd:withoutCoupon:LAST \

DEF:SIM3C=hdo~.rrd:withCoupon:LAST \

DEF:SIM3N=hdo~.rrd:withoutCoupon:LAST \

DEF:SIM4C=hdo~.rrd:withCoupon:LAST \

DEF:SIM4N=hdo~.rrd:withoutCoupon:LAST \

DEF:SIM5C=hdo~.rrd:withCoupon:LAST \

DEF:SIM5N=hdo~.rrd:withoutCoupon:LAST \

CDEF:SIM1=SIM1C,SIM1N,+ \

CDEF:SIM2=SIM2C,SIM2N,+ \

CDEF:SIM3=SIM3C,SIM3N,+ \

CDEF:SIM4=SIM4C,SIM4N,+ \

CDEF:SIM5=SIM5C,SIM5N,+ \

LINE2:SIM1#0000FF:"SIM1" \

LINE2:SIM2#00FFFF:"SIM2" \

LINE2:SIM3#00FF00:"SIM3" \

LINE2:SIM4#F00F00:"SIM4" \

LINE2:SIM5#FFFF00:"SIM5"

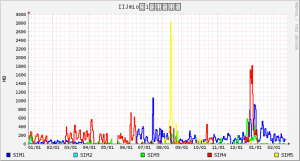

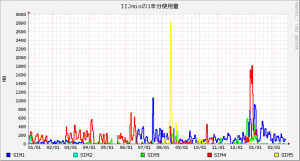

すると下記のように「IIJmioの1年分使用量」のうち日本語文字列である「の」「年分使用量」が化けている。

では、何を追加インストールすればいいのか?

CentOS5環境では「fonts-japanese」であった。

しかし、CentOS7環境ではこのパッケージ名は存在していない。

CentOS5環境でのパッケージ情報を確認

# yum info fonts-japanese

Loaded plugins: fastestmirror, priorities

base 3667/3667

Installed Packages

Name : fonts-japanese

Arch : noarch

Version : 0.20061016

Release : 4.el5

Size : 40 M

Repo : installed

Summary : フリーな日本語のビットマップ/TrueType フォント

License : Distributable

Description: This package provides the free Japanese Bitmap/TrueType fonts.

#

そして、CentOS7環境でTrueTypeで検索してみる。

# yum search "TrueType"

読み込んだプラグイン:fastestmirror, langpacks

Loading mirror speeds from cached hostfile

* base: www.ftp.ne.jp

* epel: ftp.jaist.ac.jp

* extras: www.ftp.ne.jp

* updates: www.ftp.ne.jp

============================ N/S matched: TrueType =============================

SDL2_ttf.x86_64 : TrueType font rendering library for SDL2

SDL_ttf.x86_64 : Simple DirectMedia Layer TrueType Font library

baekmuk-ttf-batang-fonts.noarch : Korean Baekmuk TrueType Batang typeface

baekmuk-ttf-dotum-fonts.noarch : Korean Baekmuk TrueType Dotum typeface

baekmuk-ttf-fonts-common.noarch : Common files for Korean Baekmuk TrueType fonts

baekmuk-ttf-fonts-ghostscript.noarch : Ghostscript files for Korean Baekmuk

: TrueType fonts

baekmuk-ttf-gulim-fonts.noarch : Korean Baekmuk TrueType Gulim typeface

baekmuk-ttf-hline-fonts.noarch : Korean Baekmuk TrueType Headline typeface

cjkuni-ukai-fonts.noarch : Chinese Unicode TrueType font in Kai face

cjkuni-uming-fonts.noarch : Chinese Unicode TrueType font in Ming face

libfonts.noarch : TrueType Font Layouting

mftrace.x86_64 : Utility for converting TeX bitmap fonts to Type 1 or TrueType

: fonts

sazanami-fonts-common.noarch : Common files for Sazanami Japanese TrueType fonts

sazanami-gothic-fonts.noarch : Sazanami Gothic Japanese TrueType font

sazanami-mincho-fonts.noarch : Sazanami Mincho Japanese TrueType font

ttembed.x86_64 : Remove embedding limitations from TrueType fonts

ttf2pt1.x86_64 : TrueType to Adobe Type 1 font converter

ttmkfdir.x86_64 : Utility to create fonts.scale files for truetype fonts

vlgothic-fonts.noarch : Japanese TrueType font

vlgothic-p-fonts.noarch : Proportional Japanese TrueType font

Name and summary matches only, use "search all" for everything.

#

「vlgothic-fonts.noarch : Japanese TrueType font」が怪しそうなので「yum install vlgothic-fonts.noarch」を実行してインストール。

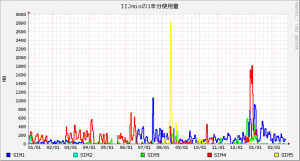

そして、rrdtoolsを再実行して生成した画像が↓

というわけで、CentOS7環境でmunin/rrdtoolsで日本語文字列が化けるときは「vlgothic-fonts」をインストールすればよい、ということがわかった。

2022/05/13追記:Oracle Linux8の場合、vlgothic-fontsはEPEL収録になっていたため、「oracle-epel-release-el8」をインストールしたあとに「vlgothic-fonts」をインストールすることになる。