2024/01/09追記: 2024/01/09にCentOS 5.11のインストールを試み、この記事の内容が引き続き使えることを確認した。(記事自体への修正はない)

検証のため古いOSを2022年にインストールしてみるシリーズ、今回はCentOS5をインストールする必要がありインストールした。(これまで「Windows Server 2008R2編」「Windows 7編」)

久しぶりすぎて忘れていたこととか、2022年の現状だと発生することとか、いろいろあったのでメモ書きとして残す。

vSphere環境上にインストールしたのだが、まず設定でいくつか問題が・・・

NICが認識できない

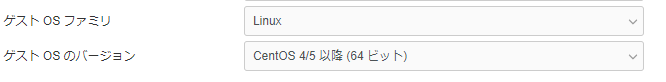

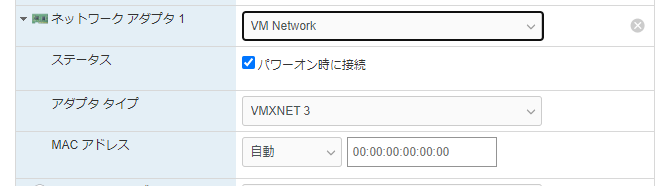

vSphere仮想マシンを新規作成する際のゲストOSを「CentOS 4/5以降 (64ビット)」で作成すると

ネットワークアダプタが「VMXNET3」として作成される。

しかし、VMXNET3のドライバはCentOS5.11のインストールISOには含まれていないため、ネットワーク接続が行えない

インストール直後からネットワーク接続を行いたい場合はアダプタタイプを「E1000」あたりで設定して作成する。

VMware Toolsが用意されていない

最近のESXiに含まれているVMware Toolsのlinux.iso にはRHEL5/CentOS5で使えるVMware Toolsが入っていない。

RHEL5/CentOS5に対応するのはVMware Tools 10.3.22までで、10.3.23以降は対応していない。

以前と同じように https://packages.vmware.com/tools/releases/10.3.22/ にあるレポジトリRPM をインストールしてyumコマンドでvmware-toolsをインストールしようとしたのですが、packages.vmware.com がTLS1.2のみ許可するWebサーバ設定となっているため、CentOS5からではファイルがダウンロードできない状態となっています。

このため https://www.vmware.com/go/tools から VMware Tools 10.3.22のダウンロードリンク から VMware Tools packages for Linuxをダウンロードして使うこととなる。

CentOS5の更新がダウンロードできない

CentOS5.11をインストールした直後の状態で yum check-update を実行すると下記のエラーとなる。

# yum check-update

Loaded plugins: fastestmirror, security

Loading mirror speeds from cached hostfile

YumRepo Error: All mirror URLs are not using ftp, http[s] or file.

Eg. Invalid release/repo/arch combination/

removing mirrorlist with no valid mirrors: /var/cache/yum/base/mirrorlist.txt

Error: Cannot find a valid baseurl for repo: base

#

これはmirrorlistでCentOS5用のファイルが提供されなくなったためのエラーとなる。

これに対してはmirrorlistではなくbaseurlに変更し、URLを「http://mirror.centos.org/centos/$releasever/~」から「http://vault.centos.org/centos/5.11/~」に書き換える、という手法が知られている。

しかし、2022年8月時点ではこの手法で書き換えた場合、「M2Crypto.SSL.SSLError: unknown protocol」というエラーで失敗する

# yum check-update

Loaded plugins: fastestmirror, security

Loading mirror speeds from cached hostfile

Traceback (most recent call last):

File "/usr/bin/yum", line 29, in ?

yummain.user_main(sys.argv[1:], exit_code=True)

File "/usr/share/yum-cli/yummain.py", line 309, in user_main

errcode = main(args)

File "/usr/share/yum-cli/yummain.py", line 178, in main

result, resultmsgs = base.doCommands()

File "/usr/share/yum-cli/cli.py", line 345, in doCommands

self._getTs(needTsRemove)

File "/usr/lib/python2.4/site-packages/yum/depsolve.py", line 101, in _getTs

self._getTsInfo(remove_only)

File "/usr/lib/python2.4/site-packages/yum/depsolve.py", line 112, in _getTsInfo

pkgSack = self.pkgSack

File "/usr/lib/python2.4/site-packages/yum/__init__.py", line 662, in <lambda>

pkgSack = property(fget=lambda self: self._getSacks(),

File "/usr/lib/python2.4/site-packages/yum/__init__.py", line 502, in _getSacks

self.repos.populateSack(which=repos)

File "/usr/lib/python2.4/site-packages/yum/repos.py", line 260, in populateSack

sack.populate(repo, mdtype, callback, cacheonly)

File "/usr/lib/python2.4/site-packages/yum/yumRepo.py", line 168, in populate

if self._check_db_version(repo, mydbtype):

File "/usr/lib/python2.4/site-packages/yum/yumRepo.py", line 226, in _check_db_version

return repo._check_db_version(mdtype)

File "/usr/lib/python2.4/site-packages/yum/yumRepo.py", line 1226, in _check_db_version

repoXML = self.repoXML

File "/usr/lib/python2.4/site-packages/yum/yumRepo.py", line 1399, in <lambda>

repoXML = property(fget=lambda self: self._getRepoXML(),

File "/usr/lib/python2.4/site-packages/yum/yumRepo.py", line 1391, in _getRepoXML

self._loadRepoXML(text=self)

File "/usr/lib/python2.4/site-packages/yum/yumRepo.py", line 1381, in _loadRepoXML

return self._groupLoadRepoXML(text, ["primary"])

File "/usr/lib/python2.4/site-packages/yum/yumRepo.py", line 1365, in _groupLoadRepoXML

if self._commonLoadRepoXML(text):

File "/usr/lib/python2.4/site-packages/yum/yumRepo.py", line 1201, in _commonLoadRepoXML

result = self._getFileRepoXML(local, text)

File "/usr/lib/python2.4/site-packages/yum/yumRepo.py", line 974, in _getFileRepoXML

cache=self.http_caching == 'all')

File "/usr/lib/python2.4/site-packages/yum/yumRepo.py", line 811, in _getFile

http_headers=headers,

File "/usr/lib/python2.4/site-packages/urlgrabber/mirror.py", line 412, in urlgrab

return self._mirror_try(func, url, kw)

File "/usr/lib/python2.4/site-packages/urlgrabber/mirror.py", line 398, in _mirror_try

return func_ref( *(fullurl,), **kwargs )

File "/usr/lib/python2.4/site-packages/urlgrabber/grabber.py", line 936, in urlgrab

return self._retry(opts, retryfunc, url, filename)

File "/usr/lib/python2.4/site-packages/urlgrabber/grabber.py", line 854, in _retry

r = apply(func, (opts,) + args, {})

File "/usr/lib/python2.4/site-packages/urlgrabber/grabber.py", line 922, in retryfunc

fo = URLGrabberFileObject(url, filename, opts)

File "/usr/lib/python2.4/site-packages/urlgrabber/grabber.py", line 1010, in __init__

self._do_open()

File "/usr/lib/python2.4/site-packages/urlgrabber/grabber.py", line 1093, in _do_open

fo, hdr = self._make_request(req, opener)

File "/usr/lib/python2.4/site-packages/urlgrabber/grabber.py", line 1202, in _make_request

fo = opener.open(req)

File "/usr/lib64/python2.4/urllib2.py", line 364, in open

response = meth(req, response)

File "/usr/lib64/python2.4/urllib2.py", line 471, in http_response

response = self.parent.error(

File "/usr/lib64/python2.4/urllib2.py", line 396, in error

result = self._call_chain(*args)

File "/usr/lib64/python2.4/urllib2.py", line 337, in _call_chain

result = func(*args)

File "/usr/lib64/python2.4/urllib2.py", line 565, in http_error_302

return self.parent.open(new)

File "/usr/lib64/python2.4/urllib2.py", line 358, in open

response = self._open(req, data)

File "/usr/lib64/python2.4/urllib2.py", line 376, in _open

'_open', req)

File "/usr/lib64/python2.4/urllib2.py", line 337, in _call_chain

result = func(*args)

File "/usr/lib64/python2.4/site-packages/M2Crypto/m2urllib2.py", line 82, in https_open

h.request(req.get_method(), req.get_selector(), req.data, headers)

File "/usr/lib64/python2.4/httplib.py", line 810, in request

self._send_request(method, url, body, headers)

File "/usr/lib64/python2.4/httplib.py", line 833, in _send_request

self.endheaders()

File "/usr/lib64/python2.4/httplib.py", line 804, in endheaders

self._send_output()

File "/usr/lib64/python2.4/httplib.py", line 685, in _send_output

self.send(msg)

File "/usr/lib64/python2.4/httplib.py", line 652, in send

self.connect()

File "/usr/lib64/python2.4/site-packages/M2Crypto/httpslib.py", line 55, in connect

sock.connect((self.host, self.port))

File "/usr/lib64/python2.4/site-packages/M2Crypto/SSL/Connection.py", line 174, in connect

ret = self.connect_ssl()

File "/usr/lib64/python2.4/site-packages/M2Crypto/SSL/Connection.py", line 167, in connect_ssl

return m2.ssl_connect(self.ssl, self._timeout)

M2Crypto.SSL.SSLError: unknown protocol

#

これは、 vault.centos.org が TLS 1.2を使用したhttpsアクセスしか受け付けなくなったが、CentOS5側ではTLS 1.2に非対応であるため、TLS 1.2が理解できず「unknown protocol」となっている、という状態である。

2022年8月時点では archive.kernel.org は http アクセスを許可してくれているため、URLを「http://archive.kernel.org/centos-vault/5.11/」に書き換えることで、CentOS5のアップデートが行えるようになる。

# CentOS-Base.repo

#

# The mirror system uses the connecting IP address of the client and the

# update status of each mirror to pick mirrors that are updated to and

# geographically close to the client. You should use this for CentOS updates

# unless you are manually picking other mirrors.

#

# If the mirrorlist= does not work for you, as a fall back you can try the

# remarked out baseurl= line instead.

#

#

[base]

name=CentOS-$releasever - Base

#mirrorlist=http://mirrorlist.centos.org/?release=$releasever&arch=$basearch&repo=os

#baseurl=http://vault.centos.org/centos/$releasever/os/$basearch/

baseurl=http://archive.kernel.org/centos-vault/5.11/os/$basearch/

gpgcheck=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CentOS-5

#released updates

[updates]

name=CentOS-$releasever - Updates

#mirrorlist=http://mirrorlist.centos.org/?release=$releasever&arch=$basearch&repo=updates

#baseurl=http://vault.centos.org/centos/$releasever/updates/$basearch/

baseurl=http://archive.kernel.org/centos-vault/5.11/updates/$basearch/

gpgcheck=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CentOS-5

#additional packages that may be useful

[extras]

name=CentOS-$releasever - Extras

#mirrorlist=http://mirrorlist.centos.org/?release=$releasever&arch=$basearch&repo=extras

#baseurl=http://vault.centos.org/centos/$releasever/extras/$basearch/

baseurl=http://archive.kernel.org/centos-vault/5.11/extras/$basearch/

gpgcheck=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CentOS-5

#additional packages that extend functionality of existing packages

[centosplus]

name=CentOS-$releasever - Plus

#mirrorlist=http://mirrorlist.centos.org/?release=$releasever&arch=$basearch&repo=centosplus

#baseurl=http://vault.centos.org/centos/$releasever/centosplus/$basearch/

baseurl=http://archive.kernel.org/centos-vault/5.11/centosplus/$basearch/

gpgcheck=1

enabled=0

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CentOS-5

#contrib - packages by Centos Users

[contrib]

name=CentOS-$releasever - Contrib

#mirrorlist=http://mirrorlist.centos.org/?release=$releasever&arch=$basearch&repo=contrib

#baseurl=http://vault.centos.org/centos/$releasever/contrib/$basearch/

baseurl=http://archive.kernel.org/centos-vault/5.11/contrib/$basearch/

gpgcheck=1

enabled=0

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CentOS-5