BIOSアップデートがDOSプログラムしかないサーバ用マザーボードで、BIOSアップデートを実施する必要が出た。

そんなわけで、DOSブート環境が必要になったわけだが、USB FDDを使うのではなく、USBメモリを使用したい、ということで調査した。

しばらく前の定番。

hpのUSB-keyメモリからのブート作成ツール

・HP Drive Key Boot Utility

cp006049.exe (45 MB) v7.41.3790.0 (8 Nov 2005)

・USB-keyメモリからのシステムブートに関して

cp004916.exe (28 MB) v7.10.3790.0

こいつをVista 64bit環境で実行したら、管理者権限+互換モードを必要とする、というのはまだいいのだが、

「フォーマット中、プログラムから応答がなくなる」

とか

「フォーマット後、ファイルが見付からない、というエラー出力」

とか

「作成できたもので結局のところブートできない」

とか発生した。

(なお、実行ファイルが日本語ディレクトリとか長いとかかな、と短い場所に置いても同現象)

代替を探したところ「RMPreUSB」がうまいこと動作した。

これの利点

・Portableエディションという、インストール不要バージョンもある

・USBメモリの認識のさせ方を3種類(FDD認識/ZIPドライブ認識/HDD認識)から選ぶことができる

・Free DOSが同梱されていてライセンスを気にしないでDOSブートできる

・DOSブート以外も作成できる

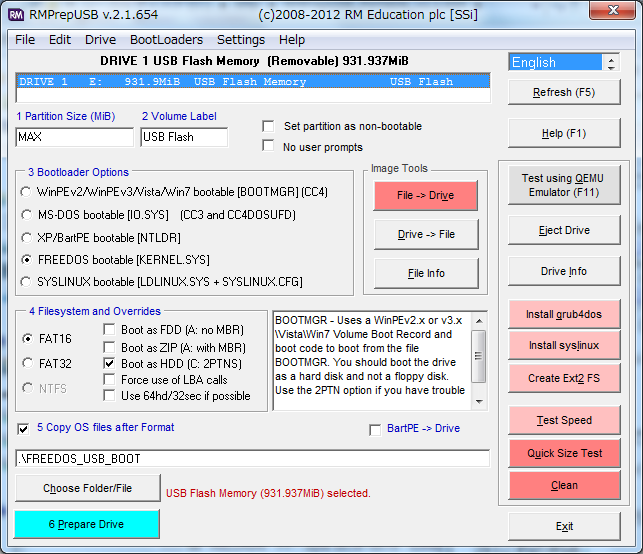

1. RMPreUSBを起動すると以下のような画面が現れる。

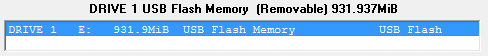

2. 以下のように、USBメモリが表示されていることを確認する。

ここで選択されているUSBメモリの内容が全て削除、フォーマットされ、DOSブートメモリとなります。

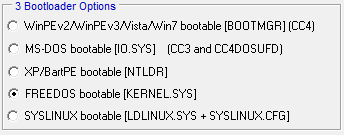

3. 「3 Bootloader Options」にて「FREEDOS bootable」を選択します。

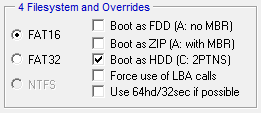

4. 「4 Filesystem and Overrides」は「FAT16」「Boot as HDD」でひとまずやってみてください。

うまくブートしなかった場合は「Boot as FDD」とか「Boot as ZIP」を試してみてください。

5. 「6 Prepare Drive」をクリックするとフォーマット開始です。

![]()

使わなかったボタンがいろいろありますが、Free DOSのブートディスクを作るくらいであれば、これだけで問題ありませんでした。