前回LTFSの現状についてまとめた記事から2年が経過した。

(「LTOテープをファイルシステムとして使うLTFSについて 2018/01/04版」)

LTO-8のテープメディアに関して発生していた特許騒動も解決し、ようやくLTO-8が普通に使える状況になりました。最近の状況について調査した。

2020/05/11 初回投稿

2020/11/11 部分修正

2021/02/04 LTFS 2.5.1対応

2021/03/10 IBM版の更新を反映

2022/04/11 ISOに関して追記。細々修正

2022/10/14 HPEとOracleの記述修正

2022/11/09 HPE StoreOpenがテープチェンジャ非対応ということが確定。オープンソース版追加

過去のLTFS関連記事

「LTOテープをファイルシステムとして使うLTFS(2012/11/28)」

「テープ装置メーカ純正のLTFS一覧(2013/12/20更新)」

「IBM版LTFSをRHEL5で使ってみた(2013/05/20)」

「LTOテープをファイルシステムとして使うLTFSについて 2014/06/09版」

「LTOテープをファイルシステムとして使うLTFSについて 2015/11/18版」

「LTOテープをファイルシステムとして使うLTFSについて 2018/01/04版」

LTFSとは?

LTO-5/LTO-6からは、メディアを2つの領域に分割して利用することが可能になった。

その機能を活かし、1本のテープメディアの中に、メディア内データの管理情報と、実データを分割して保存することを可能とした。

これにより、これまで実現出来なかった、1本のテープメディアだけで可搬性のあるファイルシステム構築、というものが可能となり、その実装として、LTFS(Linear Tape File System)というのがある。

使用用途としては、バックアップ用ではなく、長期保存のためのアーカイブ用や、大容量データの持ち運び用として使用されている。

LTFSを実現するためのソフトウェアについては、基本的には、IBMが大本のベースを作り、それを各LTOドライブメーカが、自社ドライブ向けにカスタマイズして提供しているような形となっている。

LTFSのバージョン(フォーマット)

LTFSには、バージョンがいくつかあり、現状の最新バージョンはLTFS v2.5

・LTFS 1.0

・LTFS 2.0 : ファイルインデックス関連で機能をいろいろ追加

・LTFS 2.1 : 2012/05/18リリース。LTFS2.0+シンボリックリンク

・LTFS 2.2 : 2013/12/21リリース。管理情報の改良。2016年4月にISO/IEC 20919:2016として登録

・LTFS 2.3 : 2016/03/08リリース。各ファイルのハッシュ情報とファイル名のエンコーディングを追加

・LTFS 2.4 : 2017/12/01リリース。ボリュームのロックなどの追加

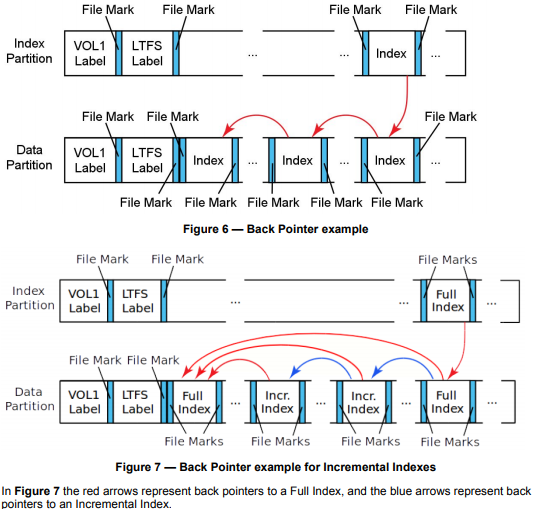

・LTFS 2.5 : 2019/05/19リリース。(Revision Historyが規格書に書かれていない…)Incremental Indexの追加

・LTFS 2.5.1: 2020/08/18リリース。細かい修正。2021年7月にISO/IEC 20919:2021 として登録

「LTFSのバージョン」と「LTFSソフトウェアのバージョン」は別物なので注意が必要。

たとえば、OracleのLTFSソフトウェアは「ver1.2.7」だが、「LTFS 2.2」に対応している。

LTFS2.2対応は重要だが、LTFS2.3対応はそれほど重要ではないので、とりあえず、現行リリースされているLTFSソフトウェアはほぼLTFS2.2以降対応なので、あまり心配しなくてもよさそう。2022/11/09時点でもLTFS v2.5対応はまだ無い模様。

LTFSv2.5の規格書はSNIAの「Linear Tape File System (LTFS)」の「Linear Tape File System (LTFS) Format Specification」にてpdfで公開されている。

LTFS v2.5で追加された「Incremental Backup」というのは、いままでは「フルバックアップ」と「前のバックアップとの増加分のバックアップ(Diff)」という2つの概念だったものが、「前のフルバックアップからの増加分のバックアップ(Incr)」が追加されたというもので、バックアップソフト側の概念としては昔からあるものになる。

その他、いろんな情報は、LTOの規格団体の「LTFS Overview」にある。

LTFSソフトウェアの種類

LTFSの公式認証を取得しているLTFSソフトウェアについては、「LTFS Compliance Verification」にて紹介されていたが、2021/03/10現在では該当ページが消滅している。

2020/05/11時点では以下の8個が登録されていた・・・「Date tested」の最新が2016年というあたりメンテナンスされていないのがわかるページだったので消滅も仕方がない感じである。

| Company | Product | Version | LTFS Version | LTO Generation | Date tested |

| Quantum | Quantum Scalar LTFS Appliance | 2.0.2 | 2.0.1 | LTO5 & 6 | 9/11/13 |

| HP | HP StoreOpen Standalone | 2.1.0 | 2.1.0 | LTO5 & 6 | 9/11/13 |

| IBM | IBM Single Drive Version | 1.3.0 | 2.1.0 | LTO5 & 6 | 9/11/13 |

| IBM | IBM LTFS Library Edition | V1R3 | 2.1.0 | LTO5 & 6 | 10/2/13 |

| Quantum | Quantum LTFS | 2.1.0 | 2.1.0 | LTO5 & 6 | 11/29/13 |

| HP | HP StoreOpen Automation | 1.2.0 | 2.0.1 | LTO5 & 6 | 11/29/13 |

| Spectra Logic | Spectra Logic Black Pearl | 1.1 | 2.2 | LTO5 & 6 | 9/11/15 |

| MT-Consulting | NODEUM | 1.1 | 2.1.0 | LTO5 & 6 | 7/05/16 |

なお、LTFSソフトウェアのバージョンと、対応しているLTFSフォーマットのバージョンに直接の関連性は無いので注意が必要。

また、LTOの規格団体の「LTFS Overview」のページに「Get Started Using LTFS」として紹介されているものは「HPE LTFS」「IBM LTFS」「Quantum LTFS (リンクは死んでいる)」の3種類である。

現状開発が継続していると思われるLTFSソフトウェアについて

・オープンソース版

よく探したらgithubにオープンソース版の開発ツリーがあった

公式: https://github.com/LinearTapeFileSystem/ltfs

単体ドライブ用で、IBM,HP,Quantumドライブに対応している

v2.4.0.0リリースからgithubに移動したらしい。

・IBM

公式: IBM Spectrum Archive(IBM Linear Tape File System)

IBMのLTFSは「IBM Spectrum Archive」という商品名になっている。テープベンダのSpectra Logicとは関係がない。

サポートURLは以前は各プロダクト用ページがあったが、2022/11/09現在は見当たらず「IBM Support」から検索、という感じのようだ。それぞれ「IBM Spectrum Archive Single Drive Edition (SDE)」「IBM Spectrum Archive Library Edition (LE)」「IBM Spectrum Archive Enterprise Edition (EE)」となる。

ドキュメントは「IBM Spectrum Archive Single Drive Edition (SDE) documentation」「IBM Spectrum Archive Library Edition (LE) documentation」「IBM Spectrum Archive Enterprise Edition (EE) documentation」。

また、アップデート用ファイルの入手は、「Fix Central」にて「製品グループ:System Storage」-「Tape Systems」-「Tape drives and software」の下にある「IBM Spectrum Archive Single Drive Edition(SDE) (旧名:LTFS Single Drive Edition)」や「IBM Spectrum Archive Library Edition(LE)(旧名:LTFS Library Edition)」「IBM Spectrum Archive Enterprise Edition(EE)」を選択することで入手する。

なお、LEとEEの方はアップデータのみの配布で、元になるソフトウェアについては、IBMから別途入手する必要がある。

基本的には、Single Drive Edition(SDE)が、他の全てのLTFSソフトウェアの原型になっているもの・・・という感じである。

2022/11/09時点での最新は、

IBM Spectrum Archive Enterprise Edition: ver1.3.3.0(2022/06/30) LTO-9対応/LTFS2.4対応

IBM Spectrum Archive Library Edition : ver2.4.5.0(2022/06/30) LTO-9対応/LTFS2.4対応

IBM Spectrum Archive Single Drive Edition: ver2.4.5.0(2022/06/30) LTO-9対応/LTFS2.4対応

・HP

公式: HPE StoreOpen and Linear Tape File System (LTFS) Software

公式2: HPE StoreOpen and Linear Tape File System (LTFS) Software

日本語情報: HP LTFS (Linear Tape File System)

HPEサポートセンター: HPE LTFS Software

以前は単体ドライブ向けの「日本語の導入マニュアル」が公開されていたがアクセスできなくなっている。

ソフトウェア関連は「HPE LTFS Software」からたどる事になる。

ソフトウェアの入手は、以前は単体ドライブ向けの「HP StoreOpen Standalone」とチェンジャー向け「HP StoreOpen Automation」が分かれていたが、現在は「HPE StoreOpen Software(LTFS)」に統合されているに統合されたことになっているのだが、試してみた感じでは単体ドライブ用の機能しかなかった。

この件について「HPE StoreOpen Software Linux and Mac 3.5 User Guide Frequently asked questions」にWindows向けStoreOpen については ver 3.4.0 以降ではライブラリ/チェンジャーに対応しているが、Linux向けについては単体ドライブしかサポートしない、との記載があることを確認した

Q: Can I use LTFS with tape libraries?

A: From v3.4, the Windows version of StoreOpen Software does offer support for HPE’s range of tape libraries; however the Linux & Mac versions do not provide such support. Tape drives located in tape libraries can be used, but there is no support for listing or changing cartridges. It may be possible to use other third party utilities for such purposes but that is beyond the scope of StoreOpen Software and HPE is unable to support customers experimenting with such configurations.

2022/11/09時点での最新は、

HP StoreOpen Software : ver3.5.0(2022/01/24) LTO-9対応/LTFS 2.4対応

また、ソースコードもダウンロードできる。

・Quantum

ソフトウェア入手は上記の公式ページの「Software」タブから行う。

ソースコードについては、LTFS Open Source Filesから。どちらも2019年から更新されていない。

2022/11/09時点での最新は下記

Linux/Mac : ver2.4.0.2(2019/03) LTO-8/LTFS2.4対応

Windows Model Bドライブ向け: ver3.0(2016/04) LTO-6以降という曖昧な記述のみ

Windows Model Cドライブ向け: ver2.4.0.2(2018/04) LTO-8/LTFS2.4対応。おそらくLinux/Mac向けと同じベース

Linux版のReleasenoteには、Quantum LTOドライブのほか、IBM LTOドライブにも対応という記述がある。

・Spectra Logic

公式:Linear Tape File System (LTFS)

LTFSを紹介するページはあるものの、LTFSを利用するソフトウェアに関するページが見当たらない。

「Spectra libraries are compatible with LTFS software and hardware solutions from a range of providers.」とあるので自社では直接提供していないようだ。

・MT-C NODEUM

公式:NODEUM

リストには「MT-Consulting」とあるが「MT-C」と改称した模様。

階層型ストレージとして、ディスクとテープなどを組み合わせて使用できるようにする、ソフトウェアのみを販売している?

リストに載っていないか死んだLTFS

・Quantum Scalar LTFS Appliance

ハードウェアがセットになったアプライアンス。

これの下にFC経由などでテープチェンジャーを繋いで使うもの。

バックアップアプライアンスに統合されたんだと思われる。

・TANDBERG DATA

2022/04/11時点のメーカWebには掲載が無くなっていたが、2022/11/09に再確認したら、「LTO Ultrium LTFS」でページは復帰していた。しかし、LTFS Softwareの入手先として「IBM SPECTRUM ARCHIVE SINGLE DRIVE EDITION」とIBM版を直接示すようになっているため、独自開発からは撤退した模様。

公式: LTFS for Archive

以前は「LTFS for Big Data」という扱いだったが、「Archive」にかえたようだ。

ソフトウェアの入手は「LTFS Downloads for LTO-5/6(legacy drive)」か「LTFS Downloads for OV-TAD LTO(LTO-7/8)」から行う。

2021/03/10時点での最新は

LTO-5/6向け: ver 3.3.0

LTO-7/8向け: ver 2.4.1.2

ページは英語表記だが、ドキュメントアイコンが日の丸になってるとおり、ダウンロードできるドキュメントはLinux用/Windows用が日本語化されている。

一部TANBERGカスタマイズが入っているようだが、基本的にはIBM Archive Single Drive Edition相当品。

・Oracle

2022/04/11時点ではメーカWebから記載が消えた。ossサイトにあったものも消えた。

2022/10/14時点では、https://lb-oss.oracle.com/projects/ltfs/ から単体ドライブ用のltfs-1.2.7が入手可能となっていた。

公式: Oracle’s StorageTek Linear Tape File System, Open Edition

以前はOracle製品としてのページ: Oracle StorageTek Linear Tape File System (LTFS), Open Edition and Library Edition があったが2021/03/10現在では消滅しているので基本は自社提供はしていないようだ。

現状でも、Oracle版のLTFSソフトウェアのうち単体ドライブ向けの入手は「https://oss.oracle.com/projects/ltfs/files/」から行うことはできる。(ライブラリ向けLTFS-LEは入手不可)

2021/03/10時点での最新は2015年時点と変わらず

ltfs-1.2.7(2015/10/07)

IBM LTFS 2.2.0.2とHP LTFS 2.2.1を組み合わせ、Oracle/StorageTek用の設定を入れたもの。

Oracle LTOドライブ,IBM LTOドライブ,HP LTOドライブに対応している。

「LTFS For Dummies」という51ページのPDFを公開しているのが興味深い。

??? For Dummiesは、アメリカで販売されているいろんな分野の初心者向け書籍シリーズ。「ダミー人形向けの」→「バカでも分かる」というものなんだけど・・・このLFS for Dummies、解説具合が微妙過ぎるなぁ・・・

「StorageTek Linear Tape File System, Library Edition Japanese Online Documentation」にて日本語ドキュメント群がhtml/pdfで公開されている。以下の4種類がすべてちゃんとした日本語なのは貴重。

「StorageTek Linear Tape File System, Library Edition 計画およびインストールガイド」

「StorageTek Linear Tape File System, Library Edition 管理ガイド」

「StorageTek Linear Tape File System, Library Edition Web サービスアプリケーションプログラミングインタフェースプログラマーズガイド」

「StorageTek Linear Tape File System, Library Edition セキュリティーガイド」

LTFS関連のツール紹介

・LTOpers

公式: https://github.com/amiaopensource/ltopers

LTFSを使いやすくするためのBASHスクリプトのフロントエンドプログラム

Quantum LTFS 2.4向けで、Homebrewでインストールし、ということなので、MacOSX向けとして作られているようだが、スクリプトを読むと.linuxbrewディレクトリがあった場合の条件分岐があるので、Linuxでも使えそう。

ドキュメント紹介

・富士通のドキュメント

富士通のWebにいくつか日本語解説ページがある。

「カートリッジテープに記録されているデータをファイル形式で扱える LTFSオプション」

「書庫探(しょこたん) > ストレージ技術用語解説 > LTFSとは」

マニュアル一覧にて「テープライブラリ (ETERNUS LT)」で検索して出てくる「ETERNUS LT series 用 LTFSオプション ユーザーズガイド」

とくに「LTFSオプション ユーザーズガイド」はLTFS全般に関して日本語で解説されているよい文章と言える

コマンド操作についてはチェンジャー/オートローダー利用時の使い方がメインであるが、単体ドライブの場合についてもだいたい同じである。

・Oracleのドキュメント

いまは更新が停止しているがOracle版ltfsについては日本語マニュアルが完備している。

「StorageTek Linear Tape File System, Library Edition Japanese Online Documentation Library

Release 1.0」

・Planning and Installation Guide

・Administration Guide

・Application Programming Interface Guide

・Security Guide